Pillole

In settimana il Parlamento Europeo dovrebbe votare la direttiva ChatControl. Una legge stupida e inutile, che vuole abolire la segretezza delle telecomunicazioni con la solita scusa di "proteggere i bambini".

Ascolta il podcast della puntata di "DataKnightmare: L'algoritmico è politico"

Puntata del 15 ottobre 2023

I sistemi di predizione del crimine non funzionano.

Negli USA, dove i sistemi predittivi cominciano ad avere una certa diffusione, è stato fatto uno studio sulla loro accuratezza: il risutato è che questa è minima, con valori <1%. Il sistema studiato è paranoico, cioè predice un numero di crimini quasi 100 volte superiore a quelli segnalati e comunque la corrispondenza tra crimini predetti e segnalati è ridicolmente bassa.

L'Antitrust USA indaga su Google ed Amazon per pratiche scorrette che porterebbero a generare situazioni di monopolio con danno ai venditori/inserzionisti e di conseguenza ai consumatori.

La Microsoft vira al nucleare: è vero? Effettivamente stanno assumendo qualcuno per studiare la fattibilità di alimentare i data center con piccoli reattori di IV generazione.

Infine, le notiziole: parliamo di un cavo sincero che ammette di mandare tutti i tuoi dati in Cina, della sparizione di un utile add-on su Firefox, della dipartita del mai dimenticato (!) VBScript e della possibilità che Windows abbia licenze in abbonamento.

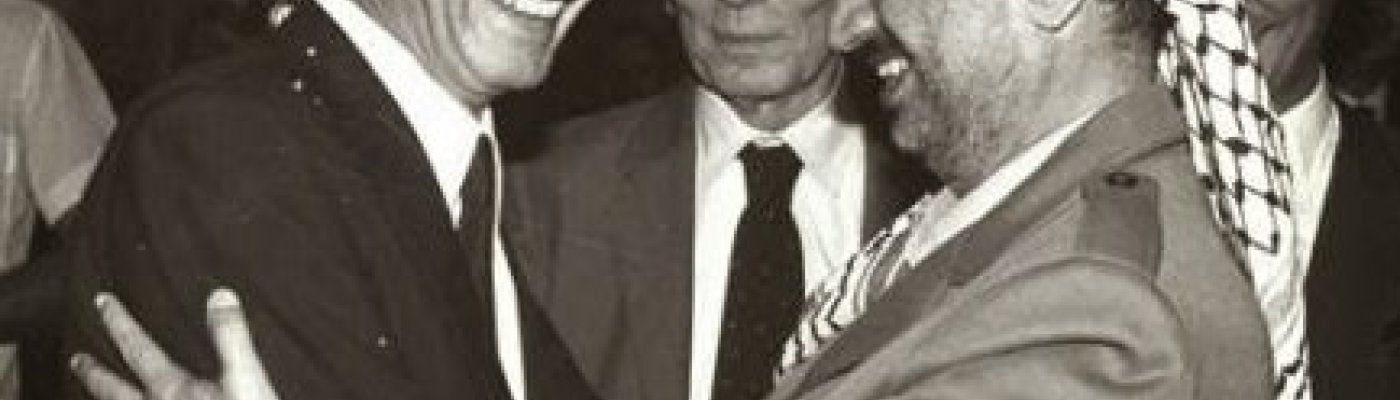

Una foto di Enrico Berlinguer con Yasser Harafat, datata 1982 e accompagnata da alcune righe sul pensiero del segretario del Pci morto nel 1984 sulla questione israelo-palestinese, tratte da una biografia scritta da Chiara Valentini. È l’ultimo post della pagina Facebook e Instagram collegata al sito enricoberlinguer.it, 500 mila e 17 mila follower ciascuna. Ma per qualche giorno non l’ha vista nessuno. “Siamo passati da migliaia di visualizzazioni l’ora a poche decine”, racconta Pierpaolo Farina, che gestisce questi account e quelli di WikiMafia, di cui è direttore. Vicenda denunciata anche sul suo sito. La pubblicazione di quel post risale al 9 ottobre, il secondo giorno dell’operazione militare di Israele sulla Striscia di Gaza, in risposta agli attacchi di Hamas del 7, che hanno fatto 1400 morti e la presa di 199 ostaggi.

L’esperienza di Farina è condivisa da centinaia di utenti dei social network: Instagram e Facebook e TikTok. In Italia come altrove.

Cassandra Crossing/ Riparare “uber alles”. Perché poter aggiustare da soli un nostro oggetto è così importante da farne una battaglia storica? Perché dovremmo scriverne ai nostri candidati eurodeputati e impegnarci personalmente?

Qualche tempo fa il governatore del Minnesota ha emanato una nuova legge per garantire il "diritto di riparare" ai cittadini del suo stato.

Per farla breve, la legge impone ai fabbricanti di prodotti colà venduti di fornire a termini "ragionevoli" entro 60 giorni gli strumenti e la documentazione per consentire ai possessori, che abbiano la fortuna di abitare in Minnesota, di riparare autonomamente i loro oggetti acquistati.

Chi in questi anni abbia letto testate tecnologiche ricorderà certamente molti articoli che parlavano di lotte tra aziende ed utenti finali per il diritto di riparare gli oggetti.

Un caso, ancora molto agli onori della cronaca, è quello della fabbrica di trattori John Deere. Questa azienda produce trattori molto tecnologici e governati da software, ed è in grado, da remoto, di bloccare le macchine vendute.

A volte osannata come tecnologia rivoluzionaria, altre volte accompagnata da dubbi e paure, l’intelligenza artificiale è stata negli ultimi mesi al centro del dibattito, purtroppo spesso inquinato da mitologie turbocapitaliste o da incomprensioni sulle sue effettive potenzialità. Partendo dallo stato della ricerca, passando per le conseguenze nel mondo del lavoro, nei rapporti geopolitici e nell’immaginario comune, proviamo a delineare un quadro realistico sul ruolo di questa tecnologia

Alune riflessioni sull'Intelligenza Artificiale e sulle possibilità di ricerca e di intervento "di parte" di Daniele Gambetta in due parti

leggi la prima parte sul sito di DinamoPress

e la seconda parte: "Technic and magic: animismo di piattaforma e svolta linguistica 2.0"

Insieme a centinaia di altri siti di tutto il mondo, il manifesto ha bloccato i software che "alimentano" le enormi banche dati private delle IA

- L'uso dei contenuti del manifesto per programmi di machine learning e IA è vietato salvo accordo scritto preventivo con la cooperativa

- Tra i principali siti del mondo, uno su quattro sta bloccando l'accesso illimitato delle IA ai propri contenuti

- E' una dichiarazione politica che mira a difendere il pubblico e la società da una espropriazione che potrebbe essere irreversibile

La comodità dei servizi di Google non è esente da inconvenienti. Per conformarsi alle leggi vigenti, le Big Tech non esitano a condividere i dati dei loro utenti con le forze dell’ordine e con i Governi che dispongono dei mandati giudiziari appropriati, una peculiarità che sta generando nuovi stratagemmi di sorveglianza e investigazione.

Recentemente, Bloomberg ha pubblicato un report in cui ha esplicitato l’esistenza di una pratica poliziesca che si appoggia sui dati di geo-fencing accumulati delle varie imprese tecnologiche. In termini semplici: le autorità costringono le aziende a comunicare quante e quali dispositivi sono transitati in una specifica area geografica durante un lasso di tempo ben definito. Queste informazioni, spesso eccessivamente dispersive, vengono successivamente raffinate richiedendo a Google di tracciare le informazioni di coloro che hanno effettuato determinate ricerche sul web. Coloro che si trovano nei punti di contingenza delle due liste finiscono spesso con l’essere indagati, poco importa che la loro presenza in loco fosse innocente o casuale.

Perché dovrei preoccuparmi se non ho nulla da nascondere.

Perché dovrei condividere con una macchina cose che, se sommate, non direi neanche alla persona più cara?

Etica Digital ha rilasciato il livello 2 di PrivaSì, la guida semplice e gratuita alla privacy in rete.

Ecco l'indice:

- Livello 0: Introduzione

- Livello 1: Limitare i danni

- Livello 2: Mezzi per muoversi

- Livello 3: Compartimentare

Il piano nazionale di ripresa e resilienza prevede diverse misure volte a potenziare e migliorare i servizi offerti dalle pubbliche amministrazioni. I fondi già assegnati in questo ambito sono circa 1,6 miliardi. Vediamo a cosa servono e come si distribuiscono sul territorio.

Sono 8 gli investimenti del Pnrr e del fondo complementare pensati per rafforzare e migliorare i servizi digitali della pubblica amministrazione.

I fondi già assegnati ammontano a circa 1,6 miliardi. La Lombardia è la regione che riceve più fondi (202,7 milioni). Seguono il Piemonte (124,5) e il Veneto (97,3).

Se si escludono i progetti di ambito nazionale, alle regioni del mezzogiorno va il 35,8% delle risorse stanziate finora.

A livello comunale, Palermo è il territorio che riceve la maggior quota di risorse (circa 3,5 milioni di euro). Seguono i comuni di Roma (2,9), Venezia (2,7) e Verona (2,5). Leggi tutto sul sito di OpenPolis

Puntata quasi monografica: a partire dalla recente entrata in vigore di una legge che permette il riutilizzo di rifiuti elettronici, parliamo non solo della legge e dei regolamenti che prescrive, ma anche del modo in cui questi ed altri regolamenti vengono creati, degli enti che scrivono i testi e di quali settori economici e sociali vengono da essi rappresentati.

Per concludere, una singola notiziola: gli ultimi iPhone sono più riparabili, sì, ma solo per Apple stessa. Tutto merito del parts-pairing.