Pillole

"Qualche giorno fa, su LinkedIn, un recruiter dichiarava di scartare tutti i candidati che non indicano competenze sull’intelligenza artificiale. Secondo lui, chi oggi non sa usare (o non dichiara di usare) l’AI non è più “occupabile”. Mi sono chiesto: cosa scriverei io, dopo trent’anni passati a lavorare con le informazioni, a progettare conoscenza, senso, orientamento? Sono forse meno competente solo perché non ho scritto “AI” nel curriculum? E allora ho provato a rispondere. Non con uno slogan. Ma con un saggio. Un saggio che parla di incertezza, di etica, di design cognitivo, di consapevolezza come forma di libertà. Un saggio che collega filosofia, teoria dell’informazione, architettura digitale e intelligenza artificiale. Perché non è l’AI che definisce la competenza, ma la capacità di dare forma al sapere. Anche — e soprattutto — quando è incerto.

Introduzione — Il valore euristico dell’incertezza

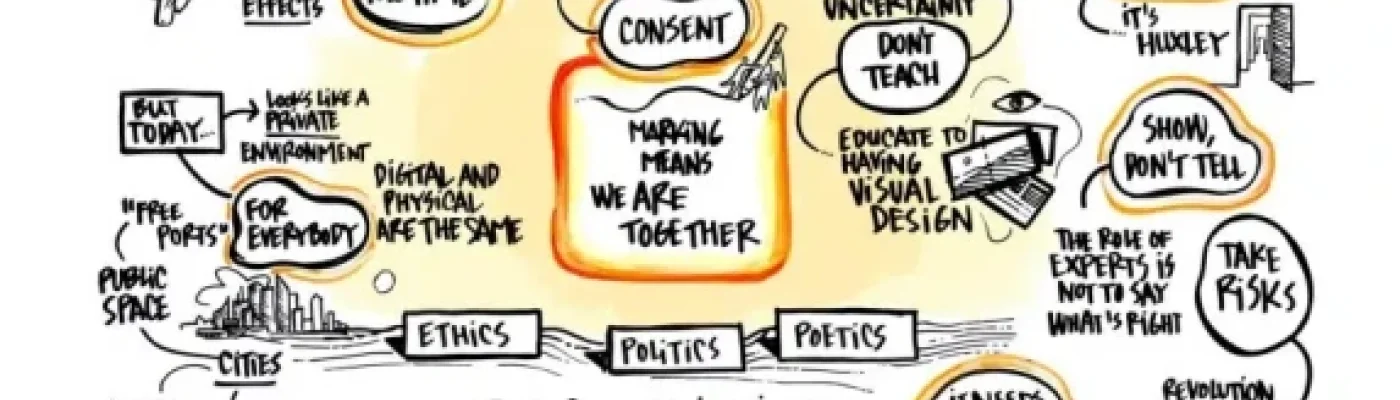

L’incertezza, lungi dall’essere un accidente della conoscenza, ne costituisce la matrice originaria. Fin dalle prime speculazioni epistemologiche, dalla aporia socratica alla sospensione del giudizio pirroniano, l’incertezza ha accompagnato la riflessione umana come segno di vitalità del pensiero e non della sua debolezza. In tempi più recenti, la filosofia della scienza ha sancito definitivamente il primato del dubbio sull’assoluto, riconoscendo nella fallibilità e nella revisione continua dei modelli conoscitivi l’unica via percorribile per l’accesso alla verità, sempre provvisoria. In questo scenario, l’informazione e le sue architetture assumono un ruolo cruciale, non tanto come dispositivi di certezza, quanto come sistemi di orientamento nell’incertezza."

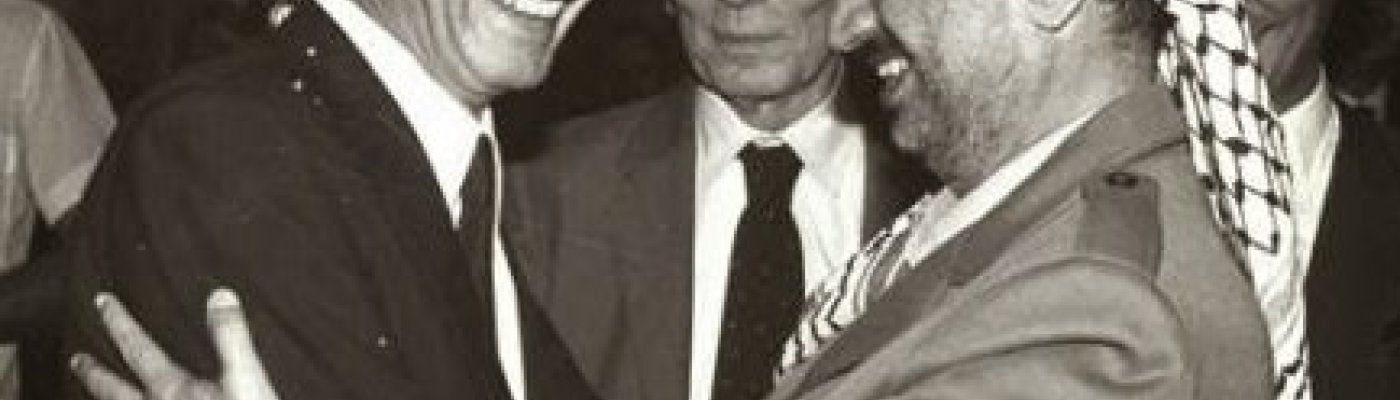

Una foto di Enrico Berlinguer con Yasser Harafat, datata 1982 e accompagnata da alcune righe sul pensiero del segretario del Pci morto nel 1984 sulla questione israelo-palestinese, tratte da una biografia scritta da Chiara Valentini. È l’ultimo post della pagina Facebook e Instagram collegata al sito enricoberlinguer.it, 500 mila e 17 mila follower ciascuna. Ma per qualche giorno non l’ha vista nessuno. “Siamo passati da migliaia di visualizzazioni l’ora a poche decine”, racconta Pierpaolo Farina, che gestisce questi account e quelli di WikiMafia, di cui è direttore. Vicenda denunciata anche sul suo sito. La pubblicazione di quel post risale al 9 ottobre, il secondo giorno dell’operazione militare di Israele sulla Striscia di Gaza, in risposta agli attacchi di Hamas del 7, che hanno fatto 1400 morti e la presa di 199 ostaggi.

L’esperienza di Farina è condivisa da centinaia di utenti dei social network: Instagram e Facebook e TikTok. In Italia come altrove.

Negli anni, Google ha cambiato in modo significativo il processo di ricerca di informazioni, aprendo intricate questioni etiche

I risultati di una ricerca su Google si sono evoluti. In risposta a un quesito, il sito da qualche anno mostra non soltanto la classica lista di link blu, ma la risposta a domande dirette e il cosiddetto "Knowledge panel", un riquadro posizionato sulla destra della pagina che fornisce informazioni generali riassuntive su un determinato argomento.

Il desiderio di Google di rispondere alle domande per noi, invece di lasciarci liberi di trovare le risposte in modo autonomo, è poco problematico se riguarda domande fattuali come la conversione tra chilometri e miglia, ma diventa pericoloso se offre informazioni sintetiche (che sono generate da un mix di algoritmi e interventi di persone interessate) su questioni più controverse.

In quest'ultimo caso il rischio di creare circoli viziosi di disinformazione è reale e accentuato dalla grande autorevolezza che gli utenti attribuiscono a Google, che da parte sua punta sempre di più su questa modalità.

(tratto da un messaggio Telegram di Etica Digitale)

Leggi l'articolo completo in inglese su wired