Pillole

Cassandra Crossing/ Le false IA commerciali che usiamo oggi sono così ambigue che non si riesce a usarle senza correre continui rischi. Anche quando si parla in confidenza.

Proprio nel giorno di San Valentino, Cassandra si è imbattuta su Gizmodo in un articolo, citato anche da Slashdot, che parlava di evidenti e gravi problemi di privacy presenti negli accordi di licenza dei "chatbot romantici".

Cosa ci insegna la storia di ELIZA, il primo chatbot che sembrava conversare come un umano. A partire da come il suo creatore divenne un critico feroce della perdita di autonomia dell’umano.

Tra i tanti ruoli che ChatGPT ha rapidamente iniziato ad assumere nelle vite dei milioni di utenti che lo utilizzano su base quasi quotidiana, ce n’è uno probabilmente inatteso. Per molti, il sistema di OpenAI con cui è possibile conversare su ogni argomento, e spesso in maniera convincente, è diventato un amico, un confidente. Addirittura uno psicologo. Una modalità non prevista (almeno esplicitamente) da OpenAI, ma scelta da un numero non trascurabile di utenti, che si relazionano a ChatGPT come se davvero fosse un analista. Per impedire un utilizzo giudicato (per ragioni che vedremo meglio più avanti) improprio e pericoloso, OpenAI impedisce al suo sistema di intelligenza artificiale generativa di offrire aiuto psicologico, che infatti di fronte a richieste di questo tipo si limita a fornire materiale utile da consultare. Ciò però non ha fermato gli “utenti-pazienti” che, su Reddit, si scambiano trucchi e tecniche per sbloccare ChatGPT affinché fornisca loro consigli psicologici.

Joseph Weizenbaum e il suo chatbot ELIZA

Un risvolto che potrebbe sorprendere molti. Uno dei pochi che sicuramente non si sarebbe sorpreso e che avrebbe avuto moltissimo da dire sull’argomento è Joseph Weizenbaum, scienziato informatico e docente al MIT di Boston, scomparso nel 2008. Colui che già parecchi decenni prima della sua morte aveva preconizzato – o meglio, affrontato e approfondito in prima persona – molti degli aspetti che portano le persone a relazionarsi in maniera intima con le macchine e le cause di questo comportamento.

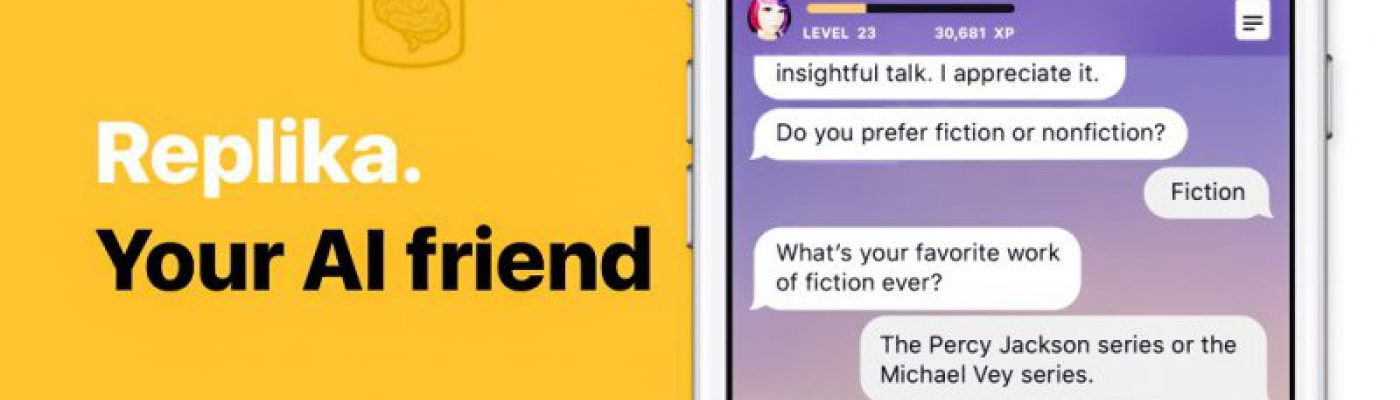

Il Garante della privacy ferma “Replika”. Il chatbot, dotato di una interfaccia scritta e vocale che basandosi sull’intelligenza artificiale genera un “amico virtuale”, per il momento non potrà usare i dati personali degli utenti italiani. Il Garante della privacy ha infatti disposto con effetto immediato, nei confronti della società statunitense che sviluppa e gestisce l’applicazione, la limitazione provvisoria del trattamento dei dati.

[...]

“Replika” viola il Regolamento europeo sulla privacy, non rispetta il principio di trasparenza ed effettua un trattamento di dati personali illecito, in quanto non può essere basato, anche solo implicitamente, su un contratto che il minorenne è incapace di concludere.

Leggi l'articolo completo sul sito del Garante Italiano per la Protezione dei Dati Personali