Pillole

Il nuovo hobby di giocare con agenti AI intelligenti è affollato di entusiasti sperimentatori. Una nuova strada che passa tra antichi problemi e porta verso nuove incertezze.

Doveva succedere, prima o poi, ed è successo la settimana scorsa. Dopo ChatGPT, è uscita una seconda killer application per le false IA. Senza preavviso, un virtuoso utente di Github ha rilasciato i sorgenti di un agente IA molto ben fatto, perfettamente funzionante, installabile e configurabile con estrema semplicità. È Peter Steinberger, una persona di indubbio ingegno che dichiara di essere un vibe coder estremo, e di pubblicare spesso codice poco leggibile e generato tramite LLM senza controllarlo.

Cos'è esattamente Openclaw? E' un software per la creazione di agenti che si installa e gira in locale sul computer dell'utente. Un agente Openclaw si interfaccia con i servizi installati sul computer, ma è concepito principalmente per utilizzare servizi in rete e nel cloud, tra cui necessariamente uno o più LLM. Openclaw utilizza gli account personali dell'utente per i servizi con cui l'agente deve interagire; questo implica che l'agente possieda le credenziali dell'utente, tutte le password, tutti i token per essere in grado di utilizzare i servizi e le varie API. Cosa mai potrebbe andare storto?

Scrivere un agente non richiede sofisticatissime nozioni, nemmeno di IA; è un argomento antico quasi quanto l'IA stessa, e in essa completamente separato dai suoi altri settori fino a pochi anni or sono. Scrivere un agente come progetto open source è un lavoro molto impegnativo per una sola persona, anche di talento;

E qui nasce la domanda: perché l'ha fatto pubblicamente un bravissimo signor nessuno, e non Sam Altman o Dario Amodei? Perché sono troppo seri? Allora perché non l'hanno fatto Elon Musk o Satya Nadella? Altro a cui pensare? Allora perché non Aravind Srinivas oppure Mustafa Suleyman? Troppo accademici? Insomma, possibile che possa essere sfuggito ai grandissimi spacciatori di LLM di cavalcare un successo assicurato, presentandolo come progetto aperto, o come prodotto commerciale, o come qualsiasi cosa nel mezzo?

Durante una recente audizione al Senato degli Stati Uniti, Waymo ha ammesso che i suoi robotaxi non sono così autonomi come la retorica aziendale lascia intendere.

Mauricio Peña, responsabile della sicurezza dell’azienda controllata da Alphabet, ha confermato che quando i veicoli incontrano situazioni insolite, il controllo viene trasferito a conducenti remoti. Molti di questi operatori non lavorano negli Stati Uniti, ma dalle Filippine e da altri paesi.

L’ammissione smonta la narrazione dell’autonomia completa e riporta al centro una realtà scomoda: dietro i sistemi di intelligenza artificiale presentati come rivoluzionari c’è ancora una certa dipendenza dal lavoro umano, spesso sottopagato e delocalizzato.

La testimonianza di Waymo non è un caso isolato ma l’ennesima conferma di un pattern industriale consolidato. L’IA si regge su una struttura ibrida in cui l’intervento umano rimane indispensabile, pur restando invisibile agli utenti finali. E il modello economico è sempre lo stesso: esternalizzare la supervisione verso paesi dove il costo del lavoro è inferiore, mantenendo però intatta la narrazione di un sistema “completamente automatizzato”.

Cassandra Crossing/ Mentre il termine “Vibe coding” perde per fortuna vigore, sempre più ambienti di programmazione forzano l’utilizzo di LLM per lo sviluppo di software; cosa mai potrebbe andare storto che già altri non abbiano evidenziato?

Pare che la produzione di software tramite l'utilizzo di modelli linguistici sia in grande sviluppo, no, in tumultuosa crescita; anzi, sia ormai divenuta inarrestabile e indispensabile. Definita inizialmente come Vibe Coding, è stata dapprima presentata come lasciapassare per chiunque volesse sviluppare software senza avere competenze di informatica e programmazione. Poi, quando la cosa ha iniziato a sembrare l'idiozia che è, si sono invece osannati i vantaggi economici che l'impiego di questi metodi da parte di veri programmatori avrebbe consentito alle aziende, aumentando la produttività dei programmatori esistenti; non è chiaro se dei senior che potevano fare a meno di una squadra di junior, oppure degli junior, che potevano scrivere software a livello di quello scritto dai senior. Comunque certamente consentendo di tagliare posti di lavoro, presenti e futuri, facendo quindi scattare quell'automatismo che fa salire subito la quotazione in borsa di qualsiasi azienda.

Alla fine, hanno iniziato a essere contrastanti i pareri di chi aveva provato davvero a usare i Grandi Modelli Linguistici (Large Language Models o LLM) in ambienti di produzione riguardo il risparmio di tempo e la qualità del codice prodotto; i primi dubbi hanno iniziato a essere presi sul serio. Lo sforzo di inserire a tutti i costi funzionalità guidate da LLM, comune a tutte le applicazioni commerciali, ha saturato di LLM anche tutti gli ambienti di sviluppo software. E quindi tutti i programmatori, che lo volessero o no, si sono trovati ad avere l'indice sul grilletto di una nuova arma.

Richard Stallman è intervenuto venerdì al Georgia Institute of Technology di Atlanta con una conferenza di circa 50 minuti, seguita da oltre un'ora e mezza di domande dal pubblico. Il fondatore del progetto GNU e figura storica del movimento del software libero ha colto l'occasione per riaffermare i principi che ne guidano da decenni l'attivismo, ma anche per aggiornare la sua critica alle tecnologie più recenti, dall'IA generativa alle auto connesse. Tra i temi toccati figurano dark pattern, censura, backdoor, abbonamenti, aggiornamenti remoti e perfino la possibilità di "brickare" da remoto i dispositivi degli utenti, che per Stallman sono tutte conseguenze dirette del software non libero.

Parlando di IA, Stallman ha contestato l'uso corrente del termine "intelligenza artificiale" per descrivere sistemi che, a suo giudizio, non sono intelligenti in alcun senso significativo. Per i grandi modelli linguistici preferisce il termine "generatori", sottolineando che generano testo senza comprenderne davvero il significato e che possono commettere errori senza alcun segnale di incertezza, motivo per cui "non ci si può fidare di ciò che generano".

Secondo Stallman, chiamarli IA equivale ad avallare l'idea che siano davvero intelligenti, contribuendo alla campagna di marketing che punta a far sì che le persone affidino attività e scelte di vita a questi sistemi e alle grandi aziende che li controllano. Per contrastare questa narrativa propone l'espressione "Pretend Intelligence", o PI, che vorrebbe diffondere proprio per smontare l'hype che circonda la tecnologia attuale. Stallman ha aggiunto che, per quanto gli risulta, nessuno di questi sistemi è distribuito come software libero, il che per lui è un ulteriore elemento problematico.

Articolo completo qui

Il 4-5-6 febbraio CIRCE partecipa alla quarta edizione del festival sulle arti inclusive #InclusiveArts2026 che investiga le pratiche di #MachineLearning nel campo dell’inclusive design e dell’accessibilità delle piattaforme digitali.

In occasione dell'evento iNCLUSIVE aRTS 2026 organizzato dal Prof. Enrico Bisenzi presso l'Accademia di Belle Arti di Roma, CIRCE è stata invitata a partecipare in modo trasversale nelle tre giornate per contribuire con uno sguardo critico ad analizzare l'impatto dell'Intelligenza Artificiale nel campo dell'Inclusive Design. Nella prima giornata, avrà luogo un laboratorio di S/gamificazione dal titolo Automazione industriale VS Intelligenza Artigianale in collaborazione con Betterpress Lab

Automazione industriale VS intelligenza artigianale: “Giocare o essere giocate” (a cura di Agnese Trocchi e Betterpress Lab)

Analisi d’interfaccia: un percorso a ritroso dal digitale all’analogico

Ogni giorno nelle nostre attività personali, di studio o di lavoro, siamo costantemente esposte a piattaforme digitali che influenzano il nostro modo di comunicare e di vivere le relazioni. Attraverso l’analisi emotiva d’interfaccia comprendiamo i meccanismi che influenzano il modo in cui viviamo le interazioni digitali, in particolare con i chatbot conversazionali. Senza accorgercene automatizziamo i nostri comportamenti per interagire con le intelligenze artificiali su cui proiettiamo caratteristiche umane. Esplorando la “zona della macchina” in cui siamo quotidianamente immerse, realizzeremo due tipi di intervento: la mattina analizzeremo le interfacce digitali di videogiochi, social media, app di messaggistica e chatbot per comprendere cosa è la gamificazione utilizzando il metodo della Pedagogia Hacker; il pomeriggio ricostruiremo in modo analogico le interfacce che più sono presenti nelle nostre vite utilizzando gli strumenti della stampa a caratteri mobili.

Tutte le informazioni sul sito di CIRCE e su quello del Prof. Enrico Bisenzi, organizzatore dell'evento.

La costruzione di data-center è in aumento in tutto il mondo per far fronte alle esigenze di calcolo e di storage della cosidetta Intelligenza Artificiale. Di pari passo crescono le proteste contro la costruzione di questi eco-mostri particolarmente energivori ed ecologicamente impattanti.

A quanto pare le proteste hanno spesso successo.

Negli Stati Uniti, secondo la rete di ricerca e attivismo Data center watch, nel secondo trimestre del 2025 venti progetti sono stati sospesi o bloccati, per un valore di 98 miliardi di dollari. Lo scorso 8 dicembre una coalizione di più di 230 gruppi ambientalisti ha richiesto una moratoria nazionale sui nuovi data center negli Stati Uniti, sollecitando il congresso a fermare la diffusione di strutture ad alto consumo energetico.

Nelle città dell’Europa del nord la rete non può reggere ulteriori infrastrutture che richiedono un alto consumo di energia, a meno di investimenti troppo costosi. E così, quando Amsterdam, Francoforte, Londra e Dublino hanno messo in pausa nuove autorizzazioni, l’attenzione si è spostata su Milano, destinata a diventare un nuovo hub a livello europeo. Così anche in Italia sono nati comitati di cittadini che protestano contro la costruzione di nuovi data-center, supportati anche da associazioni ecologiste.

Fonti:

- Internazionale, L’intelligenza artificiale fa nascere data center e proteste

- Irpi Media, I data center si mangiano la terra (ancora) verde. Due casi in Lombardia

- Mappa dei Data Center

- PuntoInformatico, Microsoft, cinque promesse per placare la rivolta anti-Data Center

- ANSA, Crescono i movimenti 'anti IA', preoccupano lavoro e data center

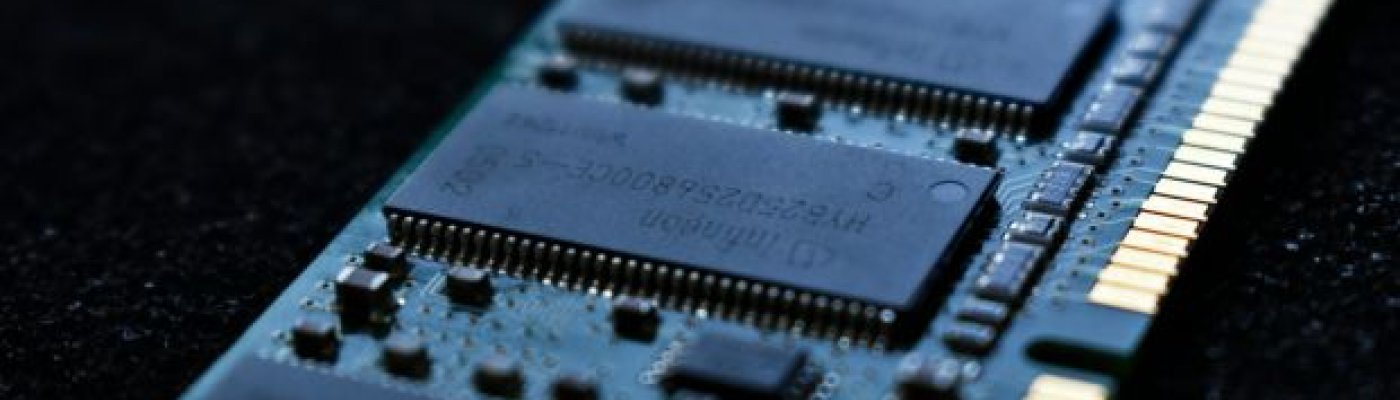

La disponibilità di memoria per PC sta attraversando una fase di tensione che sta modificando dinamiche di mercato considerate ormai consolidate. L'aumento dei prezzi delle RAM più recenti (DDR 4 e DDR 5) e la scarsità di chip stanno riportando in circolazione componenti che sembravano definitivamente superati, come i moduli DDR 3.

Negli ultimi mesi la domanda di memoria ha superato la capacità produttiva dei principali fornitori, impegnati a rifornire i datacenter in cui girano gli LLM delle varie IA, generando un incremento dei prezzi che ha colpito in modo evidente soprattutto le DDR 5. Le vendite di schede madri compatibili con DDR 5 hanno registrato un calo significativo, mentre anche le DDR 4, dopo una breve fase di stabilizzazione, hanno iniziato a mostrare segnali di indebolimento nella disponibilità, con conseguenti aumenti di prezzo.

La contrazione dell'offerta non riguarda solo i moduli di memoria, ma l'intero ecosistema necessario al loro funzionamento. La tecnologia DDR 5 integra sul modulo parte dell'elettronica di gestione dell'alimentazione, aumentando i costi di produzione e rendendo più complesso mantenere volumi elevati. Questo fattore contribuisce a spiegare perché la disponibilità sia più fragile rispetto alle generazioni precedenti.

Martedì 16 novembre si è tenuto a Torino e, contemporaneamente, in streaming il lancio della campagna “I.A., basta!” pensato dai sindacati di base, in collaborazione con l’associazione “Agorà 33 – La nostra scuola”, per «resistere all'adozione frettolosa e acritica delle intelligenze artificiali centralizzate imposte da Big Tech, come ChatGpt e Gemini», in risposta all’appello di alcuni docenti.

Lo scopo principale della campagna è far partire un dibattito che latita dall’inizio della “transizione digitale”, incentivata dai vari round di finanziamenti Pnrr Scuola. Fino a ora, infatti, si è sempre sentito parlare di “intelligenza artificiale”, strettamente al singolare, sottintendendo con questo che l’unica opzione per la scuola sia accettare “a scatola chiusa” le soluzioni delle Big Tech, oppure rigettare in toto la tecnologia alla maniera degli Amish.

Non esiste una sola intelligenza artificiale

Fin dalla prima sperimentazione, lanciata all’inizio dello scorso anno scolastico, il ministero dell’Istruzione e del Merito sembra muoversi in accordo al grido di battaglia che fu di Margaret Thatcher: «Non ci sono alternative»! La sperimentazione, partita in 15 su 8254 scuole del paese utilizzando esclusivamente prodotti Google e Microsoft, non è ancora terminata e già il Ministero ha fatto un altro possente balzo in avanti: a settembre ha presentato le “Linee guida per l’introduzione dell’I.A. nella scuola”.

A partire dal titolo del documento, emerge in maniera chiara una visione rigidamente determinista: l’intelligenza artificiale è una, quella venduta da Big Tech (OpenAi, Google, Meta, Microsoft, Anthropic), non ci sono discussioni.

Articolo completo qui

Partiamo con un report di Hackrocchio, evento organizzato dall'hacklab torinese Underscore, di cui abbiamo parlato anche recentemente.

Continuiamo passando alle Americhe, guardando agli stati che si stanno distinguendo per gli usi disparati dell'IA, soprattutto votati all'attacco alla cultura woke.

In conclusione, un approfondimento sul tema dei data center in Uruguay: un paese che si trova da anni in una situazione di siccità, ma che può offrire molta acqua per i data center di Google. Pesa, nella scelta, il fatto che l'Uruguay sia tra i paesi con la più alta percentuale di energia elettrica da fonti rinnovabili. Analizziamo quindi alcune delle questioni tecniche legate al raffreddamento dei data center.

Ascolta la trasmissione sul sito di Radio Onda Rossa

Di seguito due siti di cui si è parlato ad Hackrocchio:

Ub Scuola Università e Ricerca (Piemonte), insieme a Cobas Sicilia, Cobas Veneto e Cobas Umbria aderiscono all'appello di un gruppo di docenti italiani dopo il varo, da parte del Ministero dell'Istruzione e del Merito, delle linee guida per l'introduzione dell'intelligenza artificiale a scuola.

L'appello invita a "resistere all'adozione frettolosa ed acritica delle intelligenze artificiali centralizzate imposte da Big Tech, come ChatGPT e Gemini.

Il ministero pretende che questi software siano in grado di svolgere il ruolo di "tutor per l'apprendimento personalizzato", tacendo sul fatto che forniscono informazioni verosimili, ma false.

All'appello hanno già aderito diverse personalità storicamente attive nel movimento per il software libero, quali il prof. A.R. Meo, presidente di Assoli (ASsociazione per il SOftware LIbero www.softwarelibero.it).

Il 16 dicembre alle ore 14.30 presso la sede CUB SUR in corso Marconi 34 a Torino e online su http://lancio.vado.li si terrà una conferenza per spiegare obiettivi e tempistiche della campagna.

Maggiori informazioni e rassegna stampa sono reperibili sul sito della campagna: http://iabasta.ghost.io

Fonte Ansa