Pillole

Presentato durante il DIG Festival di Modena, racconta l'inquietante dietro le quinte di chi sostiene interi sistemi tecnologici. Ne abbiamo parlato con il regista, Henri Poulain

L’intelligenza artificiale occupa uno spazio sempre maggiore nel dibattito contemporaneo. Soprattutto al cinema dove è diventato il prisma attraverso cui si riflettono le nostre paure, le nostre speranze e le domande più radicali sull’identità umana, sul controllo della tecnologia e sul futuro della società. L’AI è diventata un vero campo di battaglia politico e sociale, dove si incontrano, e si scontrano, questioni economiche, ambientali e legate ai diritti dei lavoratori. Ancora una volta è il cinema a investigare questo rapporto complesso, mostrando cosa si nasconde dietro dati, cloud e reti digitali, grazie al prezioso documentario In the Belly of AI, diretto da Henri Poulain, presentato durante il DIG Festival di Modena.

Un’opera che smonta l’illusione di un’intelligenza artificiale immateriale e trascendente, rivelando invece quale prezzo paghiamo quotidianamente per sostenere interi sistemi tecnologici, infrastrutture che consumano e dilapidano energia, risorse naturali e vite umane. In the Belly of AI parte proprio da questo per raccontare la vita lavorativa dei data worker che, secondo un rapporto della World Bank pubblicato lo scorso anno, si stima che nel mondo siano tra i 150 e i 430 milioni, e che il loro numero sia cresciuto in modo esponenziale nell’ultimo decennio.

Seconda parte del bignamino di Quatrociocchi sugli LLM spiegati senza supercazzole.

Un LLM non è un pensatore profondo: è un sistema statistico addestrato su enormi quantità di testo per modellare le regolarità del linguaggio, senza accesso diretto al mondo reale. Tutto quello che fa è empiricamente descrivibile e riproducibile: nessuna magia, nessun “spirito” emergente.

Riporto di seguito i concetti. L'originale si può leggere su Linkedin

Walter Quattrociocchi ha pubblicato un bignamino di concetti base degli LLM. (ovvero: capire in 90 secondi un LLM e sembrare competenti a cena senza coprire l’abisso delle proprie lacune con il pensiero circolare e le supercazzole pop-filosofiche sull’etica dei termosifoni col cimurro)

Un LLM non è un pensatore profondo: è un sistema statistico addestrato su enormi quantità di testo per modellare le regolarità del linguaggio, senza accesso diretto al mondo reale. Tutto quello che fa è empiricamente descrivibile e riproducibile: nessuna magia, nessun “spirito” emergente.

Riporto di seguito i concetti. L'originale si può leggere su Linkedin

Con lo sviluppo dell’intelligenza artificiale i data center consumano sempre più acqua, lasciando a secco intere comunità

Una famiglia che abita nella contea di Newton, a un’ora e mezza in macchina da Atlanta, da diversi anni ha problemi con l’acqua. Racconta infatti il New York Times che dal 2018 la lavastoviglie, la macchina del ghiaccio, la lavatrice e il gabinetto hanno smesso uno per uno di funzionare. Poi, nel giro di un anno, la pressione dell’acqua si è ridotta a un rivolo. Finché dai rubinetti del bagno e della cucina non usciva più acqua. Nulla. Ma il problema, ovviamente, non riguarda solo questa famiglia.

[...]

Tutto questo perché? Perché dal 2018, appunto, è cominciata la costruzione del nuovo data center di Meta. I data center sono immensi centri di elaborazione dati che in breve tempo sono diventati la spina dorsale della nostra economia. Sono l’infrastruttura critica che alimenta l’archiviazione cloud, i servizi di emergenza, i sistemi bancari, le comunicazioni e la logistica. Ma sono i data center sono strutture gigantesche che consumano quantità immense di energia, suolo e acqua. Con il rapido sviluppo dell’intelligenza artificiale, questi consumi sono destinati a crescere a ritmo esponenziale.

Il caso di Jason Lemkin, dirigente d’impresa e investitore, che si è lasciato ammaliare dalle promesse dell’azienda di IA Replit, rischiando di perdere l’intero database di produzione: il cuore pulsante della sua attività professionale.

A partire dal 12 luglio, il co-fondatore di Adobe EchoSign e SaaStr ha documentato via blog la sua esperienza personale con il vibe coding. Il primo approccio è stato idilliaco: adoperando un linguaggio naturale, il manager è riuscito “in una manciata di ore a costruire un prototipo che era molto, molto fico”. Un inizio estremamente promettente, soprattutto considerando che Replit si propone alle aziende come una soluzione accessibile anche a chi ha “zero competenze nella programmazione”, promettendo di far risparmiare alle aziende centinaia di migliaia di dollari. Leggendo tra le righe, la promessa implicita è chiara: sostituire i tecnici formati con personale più economico, supportato dall’IA.

La premessa, tuttavia, è stata presto messa alla prova. “Dopo tre giorni e mezzo dall’inizio del mio nuovo progetto, ho controllato i costi su Replit: 607,70 dollari aggiuntivi oltre al piano d’abbonamento da 25 dollari al mese. Altri 200 dollari solo ieri”, ha rivelato Lemkin. “A questo ritmo, è probabile che spenderò 8.000 dollari al mese. E sapete una cosa? Neanche mi dispiace”. Anche perché, a detta del manager, sperimentare con il vibe coding è una “pura scarica di dopamina”, e Replit è “l’app più assuefacente” che abbia mai usato.

Dopo poco, il manager si è reso conto che...

Riporto un testo di Alberto Messina apparso su Linkedin.

E' da tempo che rimescolo nella testa un’analogia un po’ strana, ma che continua a sembrarmi feconda - oggi voglio condividerla per divertirmi con voi in qualche discussione:

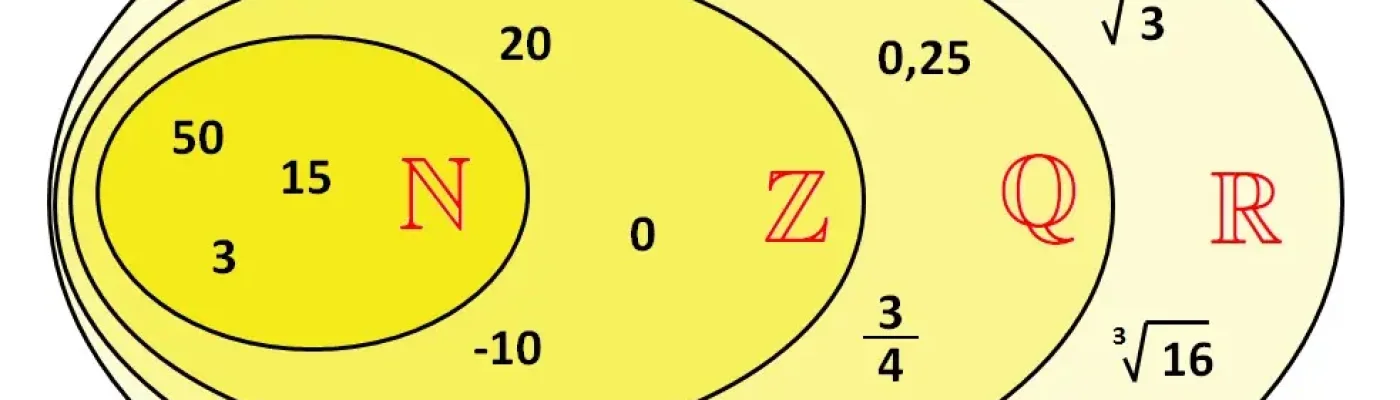

Il testo generato da un LLM sta al linguaggio umano come i numeri razionali stanno ai numeri reali.

A prima vista può sembrare poetica o azzardata, a seconda vista una supercazzola, ma esprime un punto per me importante.

I numeri razionali sono densi: tra due numeri reali qualsiasi, ce n’è sempre uno razionale. Computabili, regolari, enumerabili, possiamo generarli con regole fisse. I numeri reali, invece, includono gli irrazionali: incomprimibili, non numerabili, e molti di essi non possono essere calcolati da alcun algoritmo in maniera compiuta in un tempo finito.

Ora pensiamo ai LLM.

Essi generano testo prevedendo statisticamente il prossimo token, sulla base di grandi quantità di dati. Il risultato è fluente e denso nello spazio delle frasi plausibili. Ma, come i razionali, questa fluidità è vincolata: nasce da operazioni computabili, all’interno di un set finito di token. Non possono autonomamente inventare nuovi token, né deviare radicalmente dal sistema che li genera. Il linguaggio umano, invece, è un continuo creativo e aperto. Esso è situato in corpi, culture, storie, è affettivo, ambiguo, non deterministico. E' espandibile: possiamo coniare parole, sovvertire grammatiche, rompere aspettative. E' onomatopeico e sonoro: possiamo dire “zot!”, “sgnac”, “brummm”, “fiuuu”, senza regole o significati condivisi, ma certi che qualcuno capirà.

Infine, è spesso non computabile non perché sia casuale, ma perché è immerso in una realtà vissuta e storicamente aperta.

Una differenza profonda emerge anche dall'analogia con un principio dell’analisi matematica: l’assioma degli intervalli incapsulati: in ℝ una sequenza di intervalli "sempre più stretti" converge a un punto esatto (si perdoni la sintesi).

Nel linguaggio umano, possiamo raffinare indefinitamente ciò che vogliamo dire, e arriviamo proprio al significato, a quel concetto vissuto e condiviso con gli altri.

In un LLM, al contrario, anche con prompt sempre più precisi, si resta sempre intorno, in una serie di approssimazioni che non contengono mai davvero il punto. A me capita spesso di interagire son un chatbot per qualche minuto e poi di uscire dall'interazione per completare, per dare la pennellata essenziale al concetto.

Come le approssimazioni razionali di π, il testo di un LLM può avvicinarsi molto a quello umano. Ma c’è sempre un residuo, qualcosa che manca: la trama stessa del significato, dell’intenzione, della possibilità inventiva, del puro gioco fonico.

Questo non è un rifiuto dei LLM le loro capacità sono straordinarie. E' un promemoria: la fluidità sintattica non equivale alla profondità semantica. E l’approssimazione statistica non è comunicazione vissuta.

Non scambiamo uno spazio denso per un continuum reale.

Restiamo curiosi su ciò che questi modelli possono fare ma anche lucidi su ciò che non possono.

Lezioni di Cassandra/ L'alter ego di Cassandra ha fatto una chiacchierata eretica sulle false IA in un paio di eventi pubblici, apparentemente con una certa soddisfazione dei presenti; perché allora non trasformare gli appunti in una esternazione vera e propria, salvandoli dall'oblio digitale?

Se oggi siamo in questa situazione è tutta colpa di Joseph Weizenbaum, noto eretico dell'informatica. Anzi, è colpa di Joseph Weizenbaum e della sua segretaria. Ma andiamo con ordine.

Nell'ambito dell'intelligenza artificiale, una delle pietre miliari più conosciute è stato ELIZA, un programma informatico sviluppato appunto da Weizenbaum nel 1966, che ha rivoluzionato la nostra comprensione delle interazioni tra l'uomo e la macchina. Eliza, sebbene rudimentale rispetto agli standard odierni, ha gettato le basi per molte delle tecnologie di chatbot e assistenti virtuali che utilizziamo oggi.

[...]

In 70 anni di storia dell'IA sono stati sviluppati i motori di inferenza, le reti neurali, le tecniche di apprendimento profondo: tutte cose che nei loro ambiti funzionano benissimo. Se non li avete mai sentiti nominare, ricorderete certo le notizie che l'IA referta le TAC meglio di un radiologo e che ha battuto i campioni mondiali di scacchi e Go (dama cinese). Tre anni fa una tecnologia già nota da tempo, gli LLM (Large Language Models — Grandi modelli di Linguaggio) ha cominciato a funzionare. Perché? Per semplici motivi di scala, cioè l'utilizzo di server più potenti per eseguirli e di più informazioni con cui allenarli.

La speculazione finanziaria delle dotcom in cerca di nuove opportunità di far soldi ci si è buttata a pesce. Improvvisamente ChatGPT e i suoi fratelli sono diventati disponibili a chiunque gratuitamente: hanno cominciato ad affascinare tutti esattamente come Eliza aveva fatto con la segretaria di Weizenbaum. Ma, come Eliza, un LLM non sa niente, non comprende niente, non può rispondere a nessuna domanda e nemmeno rispondere sempre nello stesso modo.

Da culla del progressismo a cuore dell’industria bellica a stelle e strisce: Meta, OpenAI, Microsoft, Anduril e l’inarrestabile crescita della defence tech.

“C’è un sacco di patriottismo che è stato a lungo tenuto nascosto e che adesso sta venendo alla luce”, ha spiegato al Wall Street Journal, Andrew Bosworth, direttore tecnico di Meta.

Bosworth – assieme a Kevin Weil e Bob McGrew, rispettivamente responsabile del prodotto ed ex responsabile della ricerca di OpenAI, ai quali si aggiunge Shyam Sankar, direttore tecnico di Palantir – è infatti uno dei quattro dirigenti tech assoldati in quello che è stato ironicamente chiamato “Army Innovation Corps” - Corpo degli ingegneri degli Stati Uniti (il nome ufficiale del programma è Detachment 201).

Il clima che si respira oggi nella Silicon Valley è molto differente, la maschera progressista che le Big Tech hanno a lungo indossato è stata infine calata (come mostrato plasticamente dall’ormai storica foto che ritrae i principali “broligarchs” celebrare l’insediamento di Donald Trump), e adesso nessuno sembra più farsi scrupoli a seguire la strada tracciata dalle due più note realtà del settore “defence tech”: Palantir e Anduril, aziende fondate rispettivamente dall’eminenza grigia della tech-right Peter Thiel e dal guerrafondaio Palmer Luckey (già noto per aver fondato Oculus, poi acquistata da Meta, e per rilasciare dichiarazione come: “Vogliamo costruire tecnologie che ci diano la capacità di vincere facilmente ogni guerra”).

Preoccupazioni per la privacy.

L'ultimo aggiornamento di WhatsApp è pensato per mettere la IA al servizio di chi si trova spesso sommerso dalle notifiche e riesce ad accumulare decine o magari centinaia di messaggi non letti, tra i quali poi deve destreggiarsi. Con la nuova funzione Message Summaries, già attiva negli Stati Uniti, WhatsApp genera infatti riassunti automatici dei messaggi non letti, sfruttando la IA di Meta.

Il cuore della tecnologia è il Private Processing, un'infrastruttura che, secondo Meta, assicura che né Meta stessa né WhatsApp possano accedere ai contenuti delle conversazioni. I dati vengono elaborati in un ambiente protetto, al quale le richieste di elaborazione vengono inviate in modo anonimo e protette crittografia end-to-end.

La questione della riservatezza per WhatsApp è particolarmente delicata: Meta ha una storia complessa in termini di privacy.

I costi energetici di migliaia di server che effettuano miliardi di calcoli al secondo e i rischi per i cittadini

Bollette più alte e nuove centrali a gas per soddisfare la fame d’energia di Meta, il colosso tech di Mark Zuckerberg. La multinazionale sta costruendo un gigantesco data center in Louisiana, nelle campagne di Holly Ridge (una vasta area rurale nel nord-est dello stato). Sono infrastrutture strategiche per Big Tech: i data center contengono migliaia di server che, a loro volta, effettuano miliardi di calcoli al secondo, lavorando senza sosta. È il “cervello” dell’intelligenza artificiale, che se ne serve per eseguire i compiti che gli vengono commissionati o, più banalmente, per fornirci le risposte richieste. Ma proprio perché i computer lavorano ininterrottamente in condizioni normali si surriscalderebbero; dunque, per evitare guasti tecnici, vanno raffreddati artificialmente (ad esempio, tramite aria condizionata industriale ad alta potenza). Bisogna poi alimentare la potenza di calcolo e sostenere i costi energetici relativi ai sistemi d’illuminazione o di sicurezza dell’infrastruttura. In definitiva, il fabbisogno complessivo di energia dei data center è già di per sé molto elevato.

Ma Zuckerberg vuole costruire un arcipelago informatico che si estenderà su 370.000 metri quadrati (a grandi linee, un’area coperta da cinquantadue campi di calcio regolamentari). E secondo le stime di una Ong locale, Alliance for Affordable Energy, avrà bisogno del doppio dell’energia di cui vive New Orleans, una città che conta quasi quattrocentomila abitanti.