Pillole

Apriamo con una lunga analisi delle Linee guida per l'Introduzione dell'Intelligenza Artificiale nella scuola. Proseguiamo con un commento sulle dichiarazioni di Durov; e poi le nuove regole per pubblicare applicazioni su Android. Infine la rubrica notiziole.

Di Linee guida per l'Introduzione dell'Intelligenza Artificiale nella scuola se ne è già parlato all'ora di buco, ma ci torniamo sopra per parlare anche degli aspetti più prettamente tecnologici.

Per la rubrica notiziole

- Israele cede le aziende di malware agli Usa;

- l'ICE, Agenzia che si occupa della deportazione di migranti irregolari negli Usa fa shopping di prodotti di sorveglianza;

- infine, oggi le comiche, ma al massimo per 2 ore.

Le dita nella presa salterà le prossime due puntate, torniamo Domenica 2 Novembre con una puntata speciale!

Presentato durante il DIG Festival di Modena, racconta l'inquietante dietro le quinte di chi sostiene interi sistemi tecnologici. Ne abbiamo parlato con il regista, Henri Poulain

L’intelligenza artificiale occupa uno spazio sempre maggiore nel dibattito contemporaneo. Soprattutto al cinema dove è diventato il prisma attraverso cui si riflettono le nostre paure, le nostre speranze e le domande più radicali sull’identità umana, sul controllo della tecnologia e sul futuro della società. L’AI è diventata un vero campo di battaglia politico e sociale, dove si incontrano, e si scontrano, questioni economiche, ambientali e legate ai diritti dei lavoratori. Ancora una volta è il cinema a investigare questo rapporto complesso, mostrando cosa si nasconde dietro dati, cloud e reti digitali, grazie al prezioso documentario In the Belly of AI, diretto da Henri Poulain, presentato durante il DIG Festival di Modena.

Un’opera che smonta l’illusione di un’intelligenza artificiale immateriale e trascendente, rivelando invece quale prezzo paghiamo quotidianamente per sostenere interi sistemi tecnologici, infrastrutture che consumano e dilapidano energia, risorse naturali e vite umane. In the Belly of AI parte proprio da questo per raccontare la vita lavorativa dei data worker che, secondo un rapporto della World Bank pubblicato lo scorso anno, si stima che nel mondo siano tra i 150 e i 430 milioni, e che il loro numero sia cresciuto in modo esponenziale nell’ultimo decennio.

L'intervento a Radio Onda Rossa di un collaboratore di C.I.R.C.E. a proposito dell'uso dell'intelligenza artificiale nella scuola a partire dalle linee guida recentemente emanate dal Ministero dell'Istruzione evidenziandone contraddizioni, limiti e speculazioni e sottolineando l'ennesimo trasferimento di fondi pubblici ai privati, i soliti big tech.

Molto in sistesi: l'Intelligenza Artificiale delle multinazionali tecnologiche, in particolare i Large Language Model, non andrebbe usata perché è insostenibile dal punto di vista ambientale, replica discriminazioni e stereotipi della società, standardizza scrittura e pensiero.

Seconda parte del bignamino di Quatrociocchi sugli LLM spiegati senza supercazzole.

Un LLM non è un pensatore profondo: è un sistema statistico addestrato su enormi quantità di testo per modellare le regolarità del linguaggio, senza accesso diretto al mondo reale. Tutto quello che fa è empiricamente descrivibile e riproducibile: nessuna magia, nessun “spirito” emergente.

Riporto di seguito i concetti. L'originale si può leggere su Linkedin

Walter Quattrociocchi ha pubblicato un bignamino di concetti base degli LLM. (ovvero: capire in 90 secondi un LLM e sembrare competenti a cena senza coprire l’abisso delle proprie lacune con il pensiero circolare e le supercazzole pop-filosofiche sull’etica dei termosifoni col cimurro)

Un LLM non è un pensatore profondo: è un sistema statistico addestrato su enormi quantità di testo per modellare le regolarità del linguaggio, senza accesso diretto al mondo reale. Tutto quello che fa è empiricamente descrivibile e riproducibile: nessuna magia, nessun “spirito” emergente.

Riporto di seguito i concetti. L'originale si può leggere su Linkedin

I problemi delle linee guida per l’adozione dell’intelligenza artificiale in tutti gli ordini e gradi di istruzione: tra clamorose assenze, contraddizioni e ossimori. L’ennesima riforma calata dall’alto. Ma un’altra strada è possibile

Al rientro a scuola, studenti, famiglie e docenti hanno trovato l’ennesima sorpresa: un dettagliato libriccino contenente le linee guida per una rapida adozione – naturalmente consapevole, responsabile e senza ulteriori oneri a carico del bilancio – dell’intelligenza artificiale in tutti gli ordini e gradi di istruzione.

A una prima analisi, le linee guida sembrano proseguire nella spinta verso l'adozione di tecnologie digitali non facilmente controllabili dagli attori della scuola, con un forte rischio che si riproponga lo scenario già visto con i progetti PNRR Scuola 4.0: una corsa a spendere fondi per introdurre hardware e software, senza possibilità di scelta consapevole da parte delle scuole, terminata in un sostanziale trasferimento di fondi pubblici al privato. L'enfasi sull'innovazione tecnologica e sulla transizione digitale delle scuole raramente tiene conto delle esigenze didattiche della comunità scolastica, per puntare l'obiettivo su un mero accumulo di tecnologie che si rivelano ingestibili dalle scuole, vuoi per incapacità, vuoi perché le tecnologie adottate sono spesso opache, o anche perché delegate completamente a imprese private.

L'articolo di Mazzoneschi e Barale (C.I.R.C.E.) è uscito nel quotidiano Domani.

Vivere le tecnologie come se fossero qualcosa che cade dall’alto ci rende passivi e ci limita a considerare “cosa fanno” senza concentrarci sul “perché lo fanno”. È il tema centrale del libro The Mechanic and the Luddite – A Ruthless Criticism of Technology and Capitalism, scritto dal ricercatore americano Jathan Sadowski, i cui studi si concentrano sulle dinamiche di potere e profitto connesse all’innovazione tecnologica.

“Le nuove tecnologie possono catturare quantità di dati così vaste da risultare incomprensibili, ma quei dati sul mondo resteranno sempre incompleti. Nessun sensore o sistema di scraping può assorbire e registrare dati su tutto. Ogni sensore, invece, è progettato per raccogliere dati su aspetti iper-specifici. Ciò può sembrare banale, come un termometro che può restituire un numero sulla temperatura, ma non può dirti che cosa si provi davvero con quel clima. Oppure può essere più significativo, come un algoritmo di riconoscimento facciale che può identificare la geometria di un volto, ma non può cogliere l’umanità soggettiva e il contesto sociale della persona. I dati non potranno mai rappresentare ogni fibra dell’essere di un individuo, né rendere conto di ogni sfumatura della sua vita complessa.

Ma non è questo lo scopo né il valore dei dati. Il punto è trasformare soggetti umani integrati in oggetti di dati frammentati. Infatti, ci sono sistemi che hanno l’obiettivo di conoscerci in modo inquietante e invasivo, di assemblare questi dati e usarli per alimentare algoritmi di targeting iper-personalizzati. Se questi sistemi non stanno cercando di comporre un nostro profilo completo e accurato possibile, allora qual è lo scopo?

Ecco però un punto importante: chi estrae dati non si interessa a noi come individui isolati, ma come collettivi relazionali. I nostri modi di pensare la raccolta e l’analisi dei dati tendono a basarsi su idee molto dirette e individualistiche di sorveglianza e informazione.

Ma oggi dobbiamo aggiornare il nostro modo di pensare la datificazione – e le possibili forme di intervento sociopolitico in questi sistemi guidati dai dati – per includere ciò che la giurista Salomé Viljoen chiama ‘relazioni “orizzontali’, che non si collocano a livello individuale, ma a scala di popolazione. Si tratta di flussi di dati che collegano molte persone, scorrono attraverso le reti in modi tali che le fonti, i raccoglitori, gli utilizzatori e le conseguenze dei dati si mescolano in forme impossibili da tracciare se continuiamo a ragionare in termini di relazioni più dirette e individualistiche.

Leggi l'intervista completa , che ha molti altri spunti interessanti, sul sito di Guerre di rete

Con lo sviluppo dell’intelligenza artificiale i data center consumano sempre più acqua, lasciando a secco intere comunità

Una famiglia che abita nella contea di Newton, a un’ora e mezza in macchina da Atlanta, da diversi anni ha problemi con l’acqua. Racconta infatti il New York Times che dal 2018 la lavastoviglie, la macchina del ghiaccio, la lavatrice e il gabinetto hanno smesso uno per uno di funzionare. Poi, nel giro di un anno, la pressione dell’acqua si è ridotta a un rivolo. Finché dai rubinetti del bagno e della cucina non usciva più acqua. Nulla. Ma il problema, ovviamente, non riguarda solo questa famiglia.

[...]

Tutto questo perché? Perché dal 2018, appunto, è cominciata la costruzione del nuovo data center di Meta. I data center sono immensi centri di elaborazione dati che in breve tempo sono diventati la spina dorsale della nostra economia. Sono l’infrastruttura critica che alimenta l’archiviazione cloud, i servizi di emergenza, i sistemi bancari, le comunicazioni e la logistica. Ma sono i data center sono strutture gigantesche che consumano quantità immense di energia, suolo e acqua. Con il rapido sviluppo dell’intelligenza artificiale, questi consumi sono destinati a crescere a ritmo esponenziale.

Il caso di Jason Lemkin, dirigente d’impresa e investitore, che si è lasciato ammaliare dalle promesse dell’azienda di IA Replit, rischiando di perdere l’intero database di produzione: il cuore pulsante della sua attività professionale.

A partire dal 12 luglio, il co-fondatore di Adobe EchoSign e SaaStr ha documentato via blog la sua esperienza personale con il vibe coding. Il primo approccio è stato idilliaco: adoperando un linguaggio naturale, il manager è riuscito “in una manciata di ore a costruire un prototipo che era molto, molto fico”. Un inizio estremamente promettente, soprattutto considerando che Replit si propone alle aziende come una soluzione accessibile anche a chi ha “zero competenze nella programmazione”, promettendo di far risparmiare alle aziende centinaia di migliaia di dollari. Leggendo tra le righe, la promessa implicita è chiara: sostituire i tecnici formati con personale più economico, supportato dall’IA.

La premessa, tuttavia, è stata presto messa alla prova. “Dopo tre giorni e mezzo dall’inizio del mio nuovo progetto, ho controllato i costi su Replit: 607,70 dollari aggiuntivi oltre al piano d’abbonamento da 25 dollari al mese. Altri 200 dollari solo ieri”, ha rivelato Lemkin. “A questo ritmo, è probabile che spenderò 8.000 dollari al mese. E sapete una cosa? Neanche mi dispiace”. Anche perché, a detta del manager, sperimentare con il vibe coding è una “pura scarica di dopamina”, e Replit è “l’app più assuefacente” che abbia mai usato.

Dopo poco, il manager si è reso conto che...

Riporto un testo di Alberto Messina apparso su Linkedin.

E' da tempo che rimescolo nella testa un’analogia un po’ strana, ma che continua a sembrarmi feconda - oggi voglio condividerla per divertirmi con voi in qualche discussione:

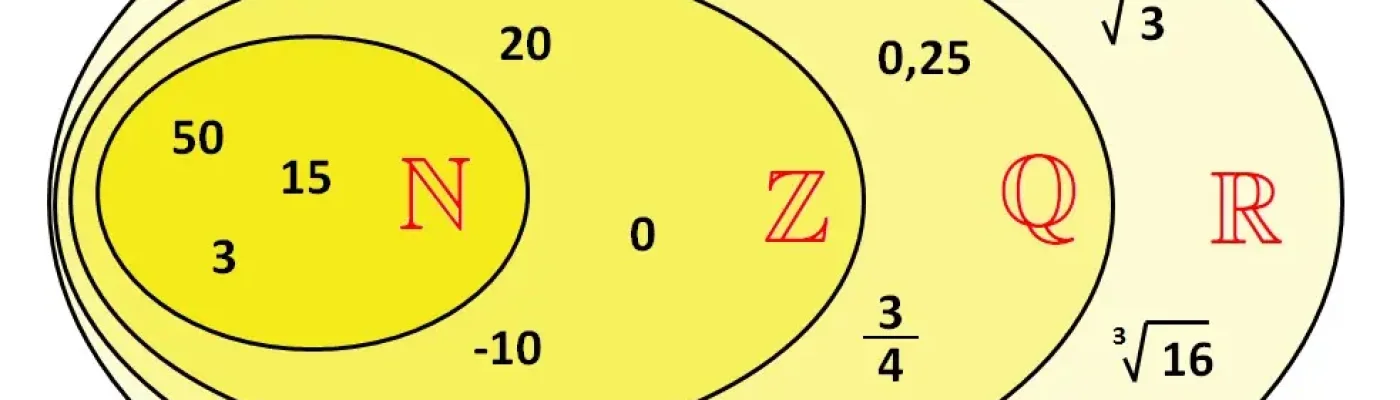

Il testo generato da un LLM sta al linguaggio umano come i numeri razionali stanno ai numeri reali.

A prima vista può sembrare poetica o azzardata, a seconda vista una supercazzola, ma esprime un punto per me importante.

I numeri razionali sono densi: tra due numeri reali qualsiasi, ce n’è sempre uno razionale. Computabili, regolari, enumerabili, possiamo generarli con regole fisse. I numeri reali, invece, includono gli irrazionali: incomprimibili, non numerabili, e molti di essi non possono essere calcolati da alcun algoritmo in maniera compiuta in un tempo finito.

Ora pensiamo ai LLM.

Essi generano testo prevedendo statisticamente il prossimo token, sulla base di grandi quantità di dati. Il risultato è fluente e denso nello spazio delle frasi plausibili. Ma, come i razionali, questa fluidità è vincolata: nasce da operazioni computabili, all’interno di un set finito di token. Non possono autonomamente inventare nuovi token, né deviare radicalmente dal sistema che li genera. Il linguaggio umano, invece, è un continuo creativo e aperto. Esso è situato in corpi, culture, storie, è affettivo, ambiguo, non deterministico. E' espandibile: possiamo coniare parole, sovvertire grammatiche, rompere aspettative. E' onomatopeico e sonoro: possiamo dire “zot!”, “sgnac”, “brummm”, “fiuuu”, senza regole o significati condivisi, ma certi che qualcuno capirà.

Infine, è spesso non computabile non perché sia casuale, ma perché è immerso in una realtà vissuta e storicamente aperta.

Una differenza profonda emerge anche dall'analogia con un principio dell’analisi matematica: l’assioma degli intervalli incapsulati: in ℝ una sequenza di intervalli "sempre più stretti" converge a un punto esatto (si perdoni la sintesi).

Nel linguaggio umano, possiamo raffinare indefinitamente ciò che vogliamo dire, e arriviamo proprio al significato, a quel concetto vissuto e condiviso con gli altri.

In un LLM, al contrario, anche con prompt sempre più precisi, si resta sempre intorno, in una serie di approssimazioni che non contengono mai davvero il punto. A me capita spesso di interagire son un chatbot per qualche minuto e poi di uscire dall'interazione per completare, per dare la pennellata essenziale al concetto.

Come le approssimazioni razionali di π, il testo di un LLM può avvicinarsi molto a quello umano. Ma c’è sempre un residuo, qualcosa che manca: la trama stessa del significato, dell’intenzione, della possibilità inventiva, del puro gioco fonico.

Questo non è un rifiuto dei LLM le loro capacità sono straordinarie. E' un promemoria: la fluidità sintattica non equivale alla profondità semantica. E l’approssimazione statistica non è comunicazione vissuta.

Non scambiamo uno spazio denso per un continuum reale.

Restiamo curiosi su ciò che questi modelli possono fare ma anche lucidi su ciò che non possono.