Pillole

Giovedì 14 dicembre alle ore 17.00 si terrà il seminario “Dalla DAD sostitutiva all’intelligenza artificiale a scuola” organizzato da CUB Scuola Università e Ricerca Torino.

Il mondo della scuola è investito dalle parole d’ordine del marketing digitale: DAD, Social, intelligenza artificiale, coding, scratch, pensiero computazionale… le novità si susseguono con ritmo battente.

La spinta del Piano Scuola 4.0, con la sua formazione “obbligatoria”, sembra voler imporre l’adozione in fretta e furia di tutto quello che le imprese del digitale mettono a disposizione.

Come fare? Respingere del tutto l’offerta di ‘novità’? L’avanzata della tecnologia è inarrestabile come uno tsunami? Non esistono tempi e modi alternativi, più conviviali?

Insieme a Carlo Milani e Stefano Borroni Barale proveremo a rispondere ad alcune di queste domande, insieme all’imperdibile dilemma: “Ma davvero ChatGPT segna la fine dei compiti a casa?”

Carlo Milani, PhD. Saggista e formatore attivo a livello internazionale con CIRCE (Centro Internazionale di Ricerca sulle Convivialità Elettriche: www.circex.org). Pratica quotidianamente la pedagogia hacker in corsi di formazione rivolti a docenti e allievi delle scuole di ogni ordine e grado. Scrive da anni di questi temi sia a livello accademico che divulgativo. Il suo ultimo libro è “Tecnologie conviviali” (Eleuthera, 2022).

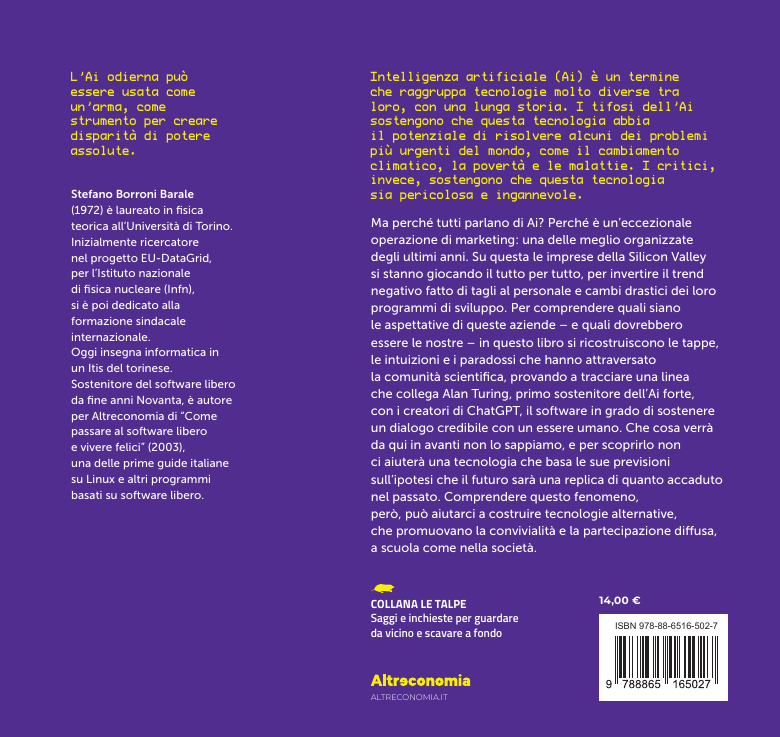

Stefano Borroni Barale. Fisico, docente di informatica e formatore sindacale sulle nuove tecnologie. Ha scritto per Altreconomia “Come passare al software libero e vivere felici” (2003), uno dei primi manuali sul tema. Il suo ultimo libro è “L’intelligenza inesistente. Un approccio conviviale all’intelligenza artificiale” (Altreconomia, 2023).

Dove: Corso Marconi 34, Torino – 2° Piano (Sede CUB SUR) Quando: Giovedì 14 Dicembre 2023 ore 17-18.30 Per chi: docenti e genitori di allievi delle superiori Come: partecipazione gratuita fino ad esaurimento posti, prenotazione obbligatoria

Form di prenotazione: https://dadia.vado.li/

giovedì 14 Dicembre 2023 ore 17:00 - 18:30

L’editore tedesco rivoluziona l’app internazionale di notizie upday e chiude la redazione italiana, licenziandone i redattori. Un caso su presente e futuro dell’informazione

Un «nuovo generatore di notizie di tendenza guidato esclusivamente dall’intelligenza artificiale» sostituirà il lavoro dei giornalisti in carne e ossa.

Mentre l’Unione europea ha varato l’Ai Act, prima legge al mondo sull’intelligenza artificiale, arriva la notizia che non è uno scenario fantascientifico di una serie tv ma la realtà di upday, app e sito internazionale di notizie che ha una testata registrata anche in Italia.

È la prima volta che i ricercatori calcolano le emissioni di anidride carbonica causate dall’utilizzo di un modello di intelligenza artificiale per diversi compiti. OpenAI, Microsoft, Google… quando soluzioni AI più green?

Ogni volta che usiamo l’AI per generare un’immagine, scrivere un’e-mail o fare una domanda a un chatbot, ha un costo per il pianeta.

Infatti, generare un’immagine utilizzando un potente modello di intelligenza artificiale richiede tanta energia quanto caricare completamente il tuo smartphone, secondo lo studio dei ricercatori della startup di intelligenza artificiale Hugging Face e della Carnegie Mellon University.

Prima di ogni raid, Israele è a conoscenza di quanti saranno i cosiddetti “danni collaterali”, ossia il numero di vittime civili che resteranno uccise in quell’operazione. È quanto rivela un’inchiesta realizzata dal magazine +972 insieme a Local Call, che si basa sulle testimonianze anonime di attuali ed ex membri dell'intelligence militare israeliana, ma anche su dati e documenti provenienti dalla Striscia di Gaza. “Nulla accade per caso”, ha spiegato una fonte che ha preferito rimanere anonima. “Quando una bambina di 3 anni viene uccisa in una casa a Gaza è perché qualcuno nell’esercito ha deciso che non era un grosso problema, che era un prezzo da pagare per colpire un altro obiettivo. Noi non siamo Hamas. Questi non sono razzi casuali. Tutto è intenzionale. Sappiamo esattamente ‘quanti danni’ collaterali ci sono in ogni casa”.

Tutto questo è possibile grazie a un software basato sull’intelligenza artificiale che permette di “generare” target da colpire a un ritmo molto più veloce di quello che era possibile fare in precedenza. Il programma si chiama Habsora, “il Vangelo”: un ex ufficiale dei servizi segreti ha dichiarato che questo sistema contribuisce a creare a Gaza una “fabbrica di uccisioni di massa”, in cui il focus “è sulla quantità e non sulla qualità”.

Leggi l'articolo completo su Valigia Blu

Sul Guardian altre informazioni sul funzionamento dell'AI usata dall'esercito Israeliano

Se l'inglese come lingua franca è molto diffusa, permettendo di allenare IA inglesi in gran parte del mondo (anche a costi irrisori in condizioni di sfruttamento), non è lo stesso per lingue come il finlandese: è per questo che la compagnia finlandese Metroc allena il suo modello linguistico tra le carceri del Paese.

Da un lato c'è chi ritiene questo lavoro (€1,54 all'ora) uno fra tanti che offre il carcere, che non sfrutta gente nel terzo mondo (vedasi OpenAI in Kenia (https://t.me/eticadigitale/753)) e che permette di mantenere vivo il patrimonio linguistico-culturale, senza lasciare il predominio linguistico ed economico all'inglese.

Dall'altro c'è invece chi critica come Metroc faccia milioni sottopagando carceratɜ, temendo che la mancanza di freni possa portare a far fare loro lavori del clic provanti, come l'esposizione a immagini disturbanti per etichettarle (vedasi Facebook, sempre in Kenia (https://t.me/eticadigitale/592))

Occorre studiare l’interfaccia di Bing se si vuole capire come sarà Google post-AI.

Google pospone l’implementazione della sua intelligenza artificiale Bard nella sua UI (User Interface) in Europa per motivi legali ma possiamo già curiosare sulla sua anteprima attraverso l’area sperimentale di Google in diversi paesi nel mondo (no Europa).

Se però vogliamo avere un’idea su come sarà l’impatto dell’AI (Artiicial Intelligence) sui motori di ricerca sia a livello di SERP (Search Engine Results Page) che a livello di ranking possiamo andare a studiare ‘dal vivo’ cosa sta già presentando Bing di Microsoft grazie alla partnership con Open AI e quindi all’integrazione nella sua interfaccia di Chat-GPT (Generative Pretrained Transformer). A livello di (top) ranking non credo che il fattore X della SEO (Search Engine Optimization) ovvero la link popularity sarà messa in discussione (qualche idea di ottimizzazione post intelligenza generativa la propongo più avanti), mentre è a livello di pagina dei risultati di ricerca che, davvero, tutto, sta per cambiare drammaticamente.

Era nata da appena una trentina di giorni; aveva solo tre dipendenti e un sito web, nessuna tecnologia da provare, nessuna metrica da mostrare negli elevator pitch, le brevi presentazioni con cui si cerca di raccogliere fondi dagli investitori. Difficile per chiunque ottenere denaro e fiducia in queste condizioni, anche nel munifico mondo delle startup tecnologiche, sensibile alle mode del momento e malato di Fomo, Fear of missing out, la paura di perdersi la prossima Google o Facebook che spinge i capitalisti di ventura a piazzare un obolo quasi ovunque.

Mistral, l’ambizione di diventare l’OpenAI europea

Eppure, nonostante il curriculum scarno, a giugno 2023 Mistral AI, neonata startup francese, è riuscita a raccogliere ben 105 milioni di euro in un round di finanziamento a un solo mese dalla nascita. Secondo Dealroom, piattaforma che monitora gli investimenti in innovazione, si tratta di un record continentale. I fondatori Timothee Lacroix, Guillaume Lample e Arthur Mensch hanno un passato in grandi società impegnate nell’intelligenza artificiale, da Google a Meta, e sono nomi rispettati nell’ambiente. Ma non basta.

Leggi l'articolo sul sito "Guerre di rete"

Leggi anche la newsletter settimanale di Carola Frediani Questa settimana:

- OpenAI “drama”

- AI Act sull’orlo di una crisi di nervi

- Ascesa di Mistral e dell’AI francese

- La storia dietro alla botnet Mirai

- Cybercrimine, porti e cocaina

Venerdì 17 novembre alle ore 18.00 Nicola Villa intervisterà Stefano Borroni Barale in occasione dell’arrivo in libreria del suo libro pubblicato da Altreconomia “L’intelligenza inesistente. Un approccio conviviale all’intelligenza artificiale”.

L’intelligenza artificiale ci viene raccontata con parole iperboliche:

- innovazione rivoluzionaria

- rischio esistenziale per l’umanità

- fattore di cambiamento totale

- rivoluzione totale dell’istruzione

Cosa c’è di vero? Come sta impattando questa ennesima invenzione tecnologica sulla scuola?

Per garantire la qualità della connessione e poter al tempo stesso, se lo volete, proporre quesiti all’autore. è richiesta gentilmente l'iscrizizone a questo link:

https://inesistentepres.vado.li/

venerdì 17 Novembre 2023 ore 18:00 - 19:00

RTT lab è la seconda tappa unplugged della comunità di Reclaim The Tech. A differenza del festival, questo meeting avrà un’impronta più laboratoriale e orientata all’incontro e al confronto: sarà un appuntamento per rilanciare il processo di Reclaim the Tech, continuare a tessere legami e alleanze, condividere saperi, iniziative, pratiche e azioni, sperimentare ambiti di progettazione comuni, ma soprattutto per riprogettare le interazioni all’interno della community e tracciare idee e proposte per il festival di Reclaim the Tech 2024.

RTT lab partirà venerdì 10 novembre alle 18.00 con l’accoglienza e la tavola rotonda di apertura su Tecnologie e saperi come terreno di conflitto, a Zero81, in collaborazione con la rivista Gli Asini.

Proseguirà per tutta la giornata di sabato 11 novembre a L’Asilo con due sessioni parallele: la mattina, con RTT deep learning and actions (tavoli di discussione tematici – in particolare sugli assi tecnologie ed educazione e tecnologie e conflitti ecologici – e mappatura). Il pomeriggio ci saranno attività di networking e conoscenza reciproca e i laboratori interattivi (che daranno vita a momenti di progettazione e sperimentazione orientati su output quali: autodifesa digitale femminista, usi alternativi e conflitti con l’IA, tecnologie partecipative, inclusive e alternative). La giornata si concluderà con la RTT night con i mini-talk (interventi, video, performance) in teatro, e la presentazione di Moleculocracy (E. Braga) in biblioteca.

Infine, domenica 12 novembre, sempre a L’Asilo, la mattina è prevista la sessione Sulle tracce di Reclaim the Tech: 2 laboratori di progettazione creativa e partecipata, uno rivolto all’ideazione dell’edizione del festival Reclaim the Tech 2024, l’altro alla ri-progettazione della community di RTT (uso, contenuti, strumenti, finalità, relazioni, partecipazione). RTT lab si chiuderà, dopo pranzo, con i saluti e la condivisione di un’agenda comune di appuntamenti e azioni.

Calcolo non è solo informatica, informatica non è solo intelligenza artificiale, intelligenza artificiale non è solo Large Language Models e agenti discorsivi che al mercato mio padre comprò.

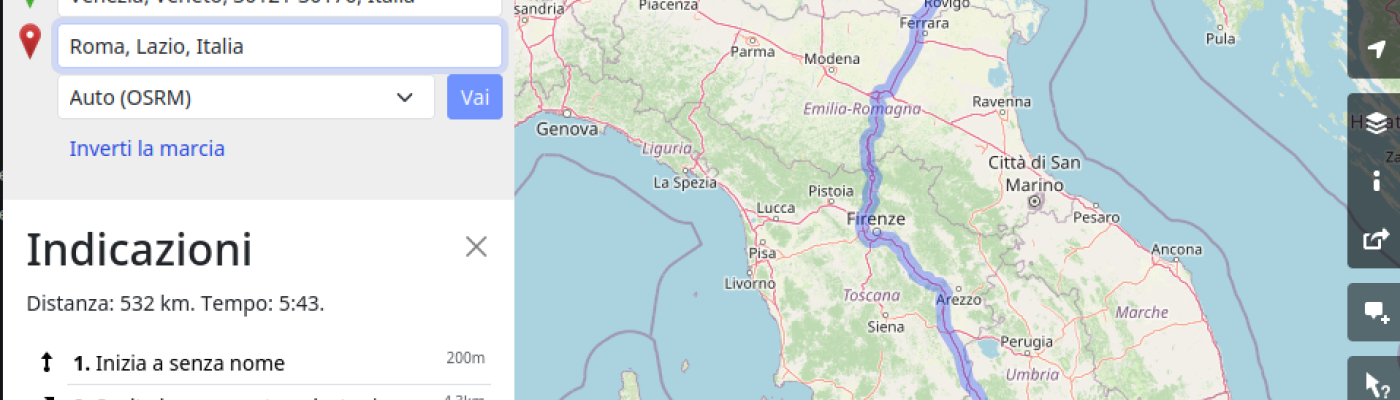

Siamo sull’autostrada A1 tra Bologna e Firenze, provenienti da Venezia. L’itinerario è molto semplice, e stimiamo di essere a casa per cena. Siccome però c’è parecchio traffico, accendiamo il navigatore (quello di serie dell’auto, una versione un po’ datata) per avere un’idea più precisa dell’ora di arrivo. Il navigatore, anzi la navigatrice, sulla base di un avviso di traffico di TMC, ci avverte che la variante “Direttissima” è chiusa al traffico e ci consiglia di prendere la “Panoramica”. L’ora di arrivo prevista è diventata 21:30, ma pazienza.

I cartelloni luminosi sull’autostrada però non ne fanno cenno. Approssimandoci al bivio vediamo che sono in tanti a prendere la Panoramica, molti più del solito. Dopo un po’ di esitazioni decidiamo di fidarci della società Autostrade per l’Italia e imbocchiamo la Direttissima, e che Dio che la mandi buona.

La navigatrice a questo punto va nel panico. Prima ci consiglia un’inversione a U, poi dice che non è in grado di suggerire nessun itinerario, poi comincia a ri-ri-ricalcolare il percorso, mostrando come ora di arrivo le 8:30 (!). Dopo un po’ di aggiustamenti (5:30, poi 2:30) si placa e ci avverte che arriveremo a casa alle 21:35 – cosa che difatti accadrà.