Pillole

La Commissione irlandese per la protezione dei dati (Dpc) annuncia una multa di 530 milioni di euro a TikTok, accusata di aver inviato illegalmente i dati degli utenti europei in Cina.

L’accusa dell’autorità è di aver trasferito illecitamente i dati degli utenti europei in Cina, aumentando per altro le tensioni e lo scetticismo (soprattutto dei legislatori occidentali) nei confronti di Bytedance, l’azienda di Pechino proprietaria del social network.

L’importo della multa è superiore alle indiscrezioni che erano trapelate a inizio mese ed è la terza sanzione più alta di sempre, dopo quelle ad Amazon (746 milioni) e Meta-Facebook (1,2 miliardi).

"Con l'invenzione e lo sviluppo della televisione, e il progresso tecnico che rese possibile di ricevere e trasmettere simultaneamente sullo stesso apparecchio, il concetto di vita privata si poteva considerare del tutto scomparso. Ogni cittadino, o meglio ogni cittadino che fosse abbastanza importante e che valesse la pena di sorvegliare, poteva essere tenuto comodamente sotto gli occhi della polizia e a portata della propaganda ufficiale"

George Orwell, l'autore del celeberrimo libro distopico 1984 dal quale sono tratte queste parole, era un ottimista. Pensava che la sorveglianza tramite la tecnologia sarebbe stata applicata solo a chi fosse abbastanza importante. Oggi, invece, la sorveglianza tecnologica si applica a tutti, in massa, e per di più siamo noi utenti a pagare per i dispositivi che la consentono.

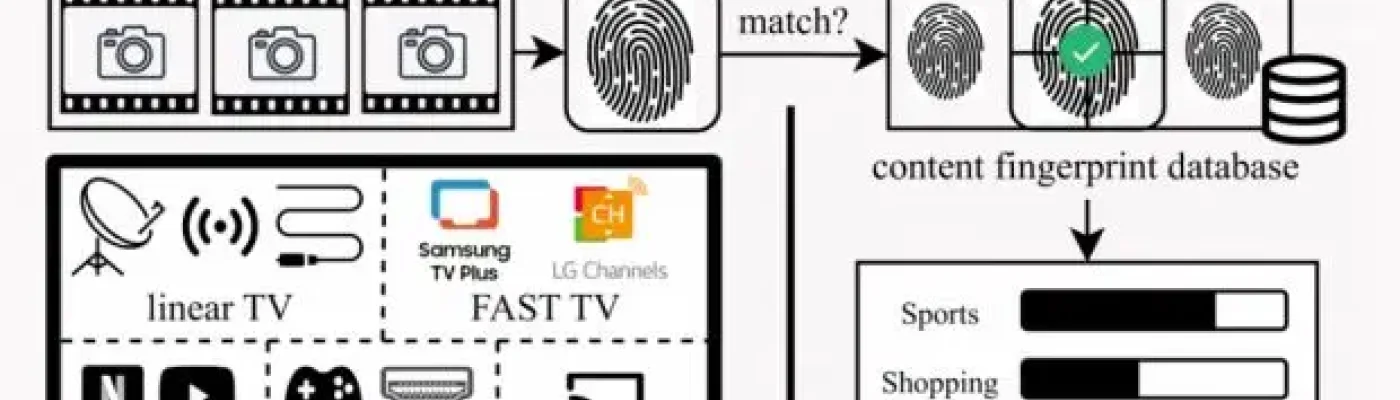

Uno di questi dispositivi è il televisore, o meglio la "Smart TV", come va di moda chiamarla adesso. Sì, perché buona parte dei televisori moderni in commercio è dotata di un sistema che raccoglie informazioni su quello che guardiamo sullo schermo e le trasmette a un archivio centralizzato. Non a scopo di sorveglianza totalitaria, ma per mandarci pubblicità sempre più mirate, basate sulle nostre abitudini e i nostri gusti. In sostanza, molti televisori fanno continui screenshot di quello che state guardando, non importa se sia una serie di Netflix, un videogioco o un vostro video personale, e li usano per riconoscere cosa state guardando e per suggerire ai pubblicitari quali prodotti o servizi mostrarvi.

È possibile impedire che l'intelligenza artificiale usi per l'addestramento ciò che abbiamo pubblicato sui social network. Ecco come

L’annuncio è arrivato lo scorso 14 aprile: Meta comincerà ad addestrare il suo modello di intelligenza artificiale Meta AI con i dati pubblicati dagli utenti di Facebook e Instagram anche in Europa. La mossa dell’azienda di Mark Zuckerberg ha immediatamente provocato un vero tsunami di reazioni (prevedibilmente) negative e la maggiore preoccupazione degli utilizzatori dei social network targati Meta, al momento, è quella di sapere come impedire l’utilizzo dei loro contenuti per foraggiare l’algoritmo.

L’azienda ha annunciato la possibilità di opporsi all’uso delle informazioni pubblicate, ma le cose non sono semplici come potrebbe sembrare. Nell’addestramento del modello, infatti, potremmo finirci anche se ci opponiamo all’utilizzo dei nostri dati.

Come anticipato da Wired, Meta AI verrà addestrata usando i “contenuti pubblici condivisi da utenti adulti”. Sono esclusi, quindi, i post e i commenti pubblicati da utenti minori di 18 anni e i messaggi privati scambiati con altri contatti. Il riferimento ai commenti pubblici escluderebbe, almeno in teoria, tutti i contenuti che vengono pubblicati con restrizioni di visualizzazione. Se abbiamo cioè impostato l’account di Facebook per consentire l’accesso ai post solo ai nostri contatti o usiamo un account Instagram privato, questi dovrebbero essere esclusi dall’addestramento di Meta AI. Vi rientrerebbero, comunque, il nome, l’immagine profilo e altri contenuti come i commenti a post pubblici, le valutazioni o recensioni su Marketplace e su un account Instagram pubblico.

Meta AI è comparsa su WhatsApp senza preavviso, generando polemiche e preoccupazioni sulla privacy. Inoltre, l’assistente virtuale introdotto forzatamente dal gruppo Zuckerberg non può essere disattivato e fornisce istruzioni fuorvianti per la rimozione.

Avete notato quel pulsantino bianco con un cerchio blu comparso di recente nella schermata di Whatsapp sul vostro smartphone? Si tratta dell’icona di Meta AI, l’intelligenza artificiale sviluppata dal gruppo di Mark Zuckerberg. Il sistema, progettato per essere semplice e intuitivo, garantisce un accesso immediato alla chatbot, la finestra di conversazione alimentata da Llama 3.2, la versione più avanzata di AI di Meta, dotata di capacità multimodali.

Violazione della privacy?

Nulla di male, in apparenza. Il problema è che Meta AI è entrato a far parte della nostra quotidianità, su milioni di schermi, senza alcuna notifica preventiva, né esplicito consenso.

Apple pagherà 95 milioni di dollari per evitare un lungo scontro in tribunale. L’accordo extragiudiziale (PDF) è stato raggiunto con lo studio legale che ha denunciato l’azienda di Cupertino per violazione della privacy. Le conversazioni degli utenti sono state registrate tramite Siri e condivise con terze parti.

Link all'articolo qui

È sufficiente una veloce ricerca su Shodan o Censys per scoprire oltre 680 stream RTSP pubblici di webcam italiane che mostrano interni di abitazioni, negozi, studi medici… senza alcuna protezione!

Nei momenti di relax mi diverte esplorare i risultati su shodan.io, piattaforma che raccoglie e indicizza le informazioni tecniche sui nodi connessi a Internet. In particolare, la sezione dedicata alle immagini, tra cui flussi RTSP, VNC e RDP, regala sempre sorprese interessanti. Per gioco ho voluto vedere se, a distanza ormai di qualche anno dai miei articoli relativamente ai rischi connessi dalle telecamere domestiche esposte su Internet senza protezione (Insecam, il database delle telecamere pubbliche (a loro insaputa), Oltre 1800 telecamere di sorveglianza italiane esposte sul Web e via dicendo), qualcosa nel panorama nazionale fosse cambiato.

È così bastata una banale query sui flussi RTSP (Real Time Streaming Protocol, il protocollo di trasmissione dati per lo streaming di flussi video, porta tcp 554) geolocalizzati in Italia per ottenere oltre 680 risultati (per la cronaca: “country:it rtsp“).

Tra i vari flussi video esposti in Rete senza protezione, troviamo case private, giardini privati, sale di attesa di studi professionali, negozi e molto altro.

Il processo a Pegasus L'azienda israeliana condannata a pagare un risarcimento al social network di Meta che verrà fissato in un secondo processo nel 2025

Venerdì 20 dicembre il tribunale del Northern District della California ha dato ragione a Whatsapp in una causa intentata dal social network contro la compagnia di spyware israeliana Nso Group, produttrice e distributrice del software Pegasus.

Per la giudice Phyllis Hamilton Nso Group ha violato la legge federale statunitense in materia di hacking e i termini di servizio di Whatsapp, sfruttando il social network per infettare più di mille smartphone con il proprio spyware Pegasus.

L’entità dei danni che Nso Group dovrà pagare a Whatsapp sarà stabilità in un secondo processo l’anno prossimo.

Pegasus era stato sviluppato da Nso Group nel 2011 e promosso tra le agenzie governative internazionali come strumento per combattere terrorismo e criminalità organizzata.

La Commissione irlandese per la protezione dei dati (Dpc) ha emesso una sanzione di 251 milioni di euro nei confronti di Meta, la società madre di Facebook, per aver trasgredito le normative europee sulla privacy dei dati (Gdpr).

La multa, annunciata martedì 17 dicembre, è il risultato di un’indagine su una violazione di sicurezza risalente a luglio 2017, che ha compromesso oltre tre milioni di account nel territorio dell’Unione Europea.

“Gli individui sono stati esposti a rischi significativi per i loro diritti fondamentali a causa della mancata integrazione dei requisiti di protezione dei dati”, ha affermato Graham Doyle, vice commissario del Dpc irlandese.

La falla è stata causata da un errore di progettazione nella piattaforma Facebook, che ha consentito a soggetti non autorizzati di accedere a profili utente non altrimenti visibili.

Clicca qui per l'articolo completo.

Il primo rapporto di revisione sul Data Privacy Framework (DPF), pubblicato dall’European Data Protection Board (EDPB) il 4 novembre 2024, segna una tappa decisiva nel monitoraggio della protezione dei dati personali dei cittadini europei trasferiti verso gli Stati Uniti.

Nato come risposta alla sentenza “Schrems II” della Corte di Giustizia dell’Unione Europea (CGUE), che nel 2020 aveva invalidato il Privacy Shield per carenze di tutela, il DPF cerca di rispondere alle esigenze di bilanciamento tra diritti individuali e interessi di sicurezza nazionale statunitensi, introducendo principi quali la necessità e la proporzionalità nelle operazioni di sorveglianza.

L’EDPB, tuttavia, osserva come le misure implementate dal DPF, sebbene migliorative, lascino aperte questioni rilevanti sulla reale equivalenza delle garanzie offerte rispetto a quelle europee.

In particolare, il report solleva dubbi riguardo alla trasparenza delle pratiche di raccolta dati e all’efficacia del meccanismo di ricorso, un sistema teoricamente aperto ai cittadini europei per ottenere rimedi in caso di violazione dei loro diritti.

Guardare avanti, si dice. Guardare fisso, invece, la propria mano che sostiene un apparecchietto nero con schermo, detto smartphone. Consultare, sbirciare, controllare, scrollare, ascoltare, pagare, scrivere, parlare, filmare… Al ristorante, per strada, in chiesa, nel passeggino, al cinema, in arrampicata, al supermercato, in auto, in classe, in ospedale, sul bus, sul water, a letto, in bici, al lavoro, ai mari e ai monti… in tasca, in mano. A testa bassa.

Paesaggio umano smisuratamente social. Ognuno di noi al guinzaglio del proprio smartphone. Ad ogni latitudine, più o meno. Ad ogni età, neonato e pensionato, per ogni sesso. Super intersezionale. La psichiatria, che ha il naso fino, ha inventato il problematic smartphone use (PSU) Ma quale problematic? Obvious smartphone use. Non è un gingillo, è una Lampada di Aladino dai mille favori. È un essere più che uno strumento tecnico. Non sono un filosofo e torno a incantarmi con questo congegno luccicante che ci ha catturati, dionisiacamente “sussunti” direbbero gli intenditori. Se fossi nato vent’anni fa non mi stupirebbe toccar quotidianamente con mano la nostra universale dedizione all’Angelo Custode che ogni giorno ci accompagna e ci nutre, mi sarebbe risuonato perfettamente naturale, oggettivo, da sempre. Una felice evoluzione dell’umanità.

Di chi è figlia questa alchimia universale? Del capitalismo digitale, di quello cognitivo, di quello zombi? Di un neo colonialismo psichico? Di una fantomatica tecnodittatura? Di un dio cattivo, o anche buonino, che escogita una nuova religione? Di quei cinque o sei giovanottoni diventati paperon de’ paperoni giocando con il web e inventando questo e quello? Di un presente a capitalismo morto, che sarebbe ancora peggio del capitalismo vivo? Di me boccalone e dei miei simili che ci facciamo accalappiare da questa sbalorditiva pietra filosofale rettangolare?