Pillole

Google ha dovuto sospendere la funzione di Gemini di generare immagini dopo essere stato accusato di negare la realtà storica rappresentando come nere figure che storicamente non potevano esserlo. Ecco come nel tentativo di superare gli stereotipi razziali e di genere, il chatbot è finito nei guai.

Forse le intenzioni erano buone, ma i risultati non lo sono stati affatto. Così, oltre a scusarsi, Google ha deciso di sospendere il generatore di immagini della sua intelligenza artificiale Gemini, dopo essere finito al centro della polemica per aver creato una serie di immagini storiche che sono state accusate di "revisionismo storico". Ma cos'è successo?

A volte osannata come tecnologia rivoluzionaria, altre volte accompagnata da dubbi e paure, l’intelligenza artificiale è stata negli ultimi mesi al centro del dibattito, purtroppo spesso inquinato da mitologie turbocapitaliste o da incomprensioni sulle sue effettive potenzialità. Partendo dallo stato della ricerca, passando per le conseguenze nel mondo del lavoro, nei rapporti geopolitici e nell’immaginario comune, proviamo a delineare un quadro realistico sul ruolo di questa tecnologia

Alune riflessioni sull'Intelligenza Artificiale e sulle possibilità di ricerca e di intervento "di parte" di Daniele Gambetta in due parti

leggi la prima parte sul sito di DinamoPress

e la seconda parte: "Technic and magic: animismo di piattaforma e svolta linguistica 2.0"

Una palaquium gutta matura poteva produrre circa 300 grammi di lattice. Ma nel 1857, il primo cavo transatlantico era lungo circa 3000 km e pesava 2000 tonnellate – richiedeva quindi circa 250 tonnellate di guttaperca. Per produrre una sola tonnellata di questo materiale erano necessari circa 900.000 tronchi d'albero. Le giungle della Malesia e di Singapore furono spogliate, e all'inizio del 1880 la palaquium gutta si estinse.

Questa è una delle storie più interessanti che racconta il libro della studiosa di media digitali Kate Crawford, Né artificiale né intelligente. Il lato oscuro dell’IA (Il Mulino, 2021, 312 pp., versione italiana dell’originale inglese Atlas of AI. Power, Politics and the Planetary Costs of Artificial Intelligence, Yale University Press, 2021).

Ma cosa c’entra il disastro ambientale vittoriano della guttaperca con l’intelligenza artificiale?

È proprio questo il merito del libro della Crawford, unire i puntini che legano la storia dello sviluppo tecnologico con il nostro presente. La storia di come si estinse l’albero di palaquium gutta è un’eco giunta fino a noi dalle origini della società dell’informazione globale, per mostrarci come siano intrecciate le relazioni tra la tecnologia e la sua materialità, l’ambiente e le diverse forme di sfruttamento.

[...]

Crawford costruisce una visione dell’IA non come una semplice tecnologia o un insieme di scoperte tecnologiche, ma come un apparato socio-tecnico, o socio-materiale, animato da una complessa rete di attori, istituzioni e tecnologie. L’IA per Crawford è “un’idea, un’infrastruttura, un’industria, una forma di esercizio del potere; è anche una manifestazione di un capitale altamente organizzato, sostenuto da vasti sistemi di estrazione e logistica, con catene di approvvigionamento che avviluppano l’intero pianeta” (p. 25).

Leggi l'articolo intero di Tiziano Bonini sul sito di DOPPIOZERO

Nella quarta puntata del ciclo "Estrattivismo dei dati", focus su Intelligenza Artificiale con Daniela Tafani, docente di filosofia politica presso il Dipartimento di Scienze Politiche dell'Università di Pisa.

Nella prima parte Tafani introduce l'Intelligenza Artificiale. Cosa è; le distorsioni con cui viene volutamente presentata; cos'è l'apprendimento automatico e gli ingredienti tecnologici fondamentali: dati, potenza di calcolo e algoritmi.

Nella seconda parte: come vengano occultati i costi ambientali, estrattivistici ed energetici dei sistemi di IA; come viene in realtà sfruttato massicciamente il lavoro umano, sottopagato e delocalizzato.

Nella terza parte: i rischi delle decisioni automatizzate prese attraverso i sistemi di Intelligenza Artificiale, con la convinzione che siano capaci di prevedere il comportamento di singoli individui. Perché si parla di bolla giuridica e perché si propone l’illegalità di default dei sistemi di IA.

Ascolta la registrazione sul sito di Radio Onda Rossa

Numero molto interessante della newsletter di Carola Frediani, dedicata in larga misura all'hype (tradotto da wordreference con battage publicitario) sull'Intelligenza Artificiale

L'indice del numero N.150 - 21 gennaio 2023

- Il 2023 sarà l’anno della corsa all’AI?

- Il forte lascito di Aaron

- Il difficile rapporto tra Ue, media e piattaforme

- I politici finanziati da FTX

- E altro

Leggi la newsletter sul sito.

Riporto una definizione di ChatGPT frutto del dibattito nella mailing-list pubblica del Centro NEXA su Internet & Società del Politecnico di Torino (Dipartimento di Automatica e Informatica):

"ChatGPT produce testo 'finito' combinando stringhe di testo del cui significato non sa nulla, in modo statisticamente coerente con l'uso di queste stringhe nei testi con cui è stato programmato. Il testo prodotto non ha perciò alcun valore informativo o intento comunicativo. ChatGPT non è programmato per produrre risposte corrette, ma sequenze di parole che siano statisticamente simili a quelle presenti nei testi scelti dai programmatori."

L’Intelligenza artificiale è spesso al servizio di progetti autoritari che accrescono le disuguaglianze e mettono a rischio la democrazia. Parla lo studioso Dan McQuillan

Serve «un approccio antifascista all’intelligenza artificiale», scrive Dan McQuillan nel suo recente volume intitolato “Resisting Ai” (Bristol University Press). Non perché l’Ia sia di per sé fascista, ragiona il docente di Computing sociale e creativo al Goldsmiths College dell’università di Londra, ma in quanto motore di dinamiche congruenti, e in modo strutturale, con politiche fasciste. Lungi dall’essere una mera tecnologia, l’Ia è infatti un “apparato” che somma tecnica, istituzioni e ideologia. E se ne comprendiamo le “operazioni di base”, e le situiamo nell’attuale momento storico, è impossibile ignorare che il cambiamento di paradigma sociale portato dall’Ia «non farà che amplificare politiche di austerity e sviluppi autoritari», si legge nel testo, agile ma durissimo di McQuillan.

[...] Per l’autore, che vanta un dottorato in fisica delle particelle e un passato come direttore delle comunicazioni digitali di Amnesty, il legame tra fascismi e Ia si salda prima, all’incrocio tra le crescenti richieste di efficienza e risparmi nella gestione della cosa pubblica e l’ideologia che fa dell’intelligenza artificiale la panacea, infallibile e oggettiva, di ogni male. È il cosiddetto “soluzionismo”, che riduce problemi sociali complessi - la pandemia, l’emergenza climatica, la questione energetica - a questioni tecnologiche, risolvibili tramite Ia. Tutto diventa materia di “ottimizzazione” statistica. E, in fondo, questo è l’Ia secondo McQuillan: non “intelligenza” - l’autore sembra fare sua la fortunata espressione della ricercatrice Kate Crawford, per cui l’Ia «non è né intelligente né artificiale» - ma «elaborate congetture statistiche», informate da una visione «astrattamente utilitarista» che finisce per insieme nascondere, riprodurre e amplificare ingiustizie e storture sociali, automatizzandole.

Leggi l'articolo di Fabio Chiusi sul sito dell'Espresso

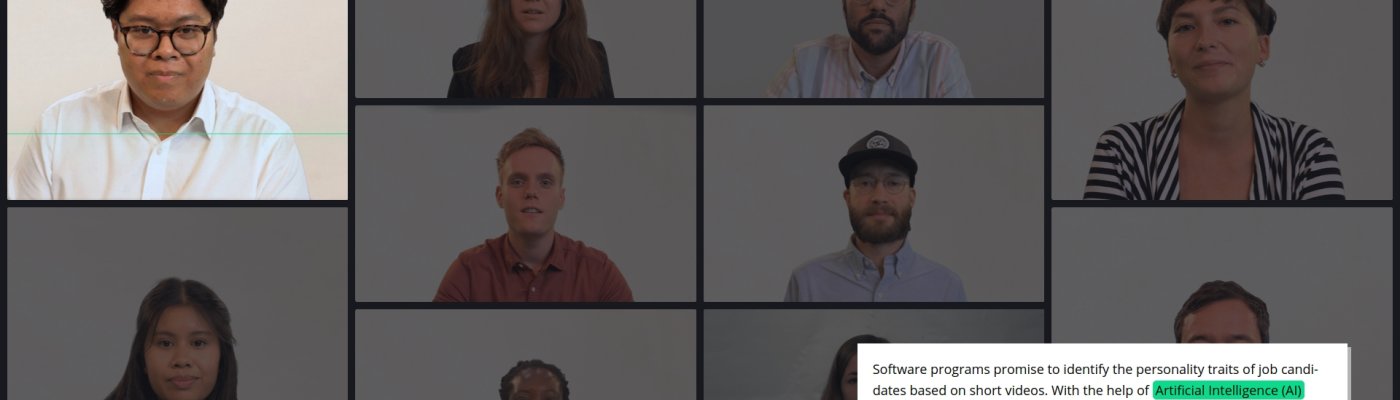

Una interessante inchiesta sul discutibile uso dell'Intelligenza Artificiale per la selezione di domande di lavoro.

I software per la selezione del personale promettono di identificare i tratti della personalità dei candidati al lavoro sulla base di brevi video. Con l'aiuto dell'Intelligenza Artificiale (IA), dovrebbero rendere il processo di selezione dei candidati più obiettivo e veloce.

L'inchiesta di alcuni giornalisti della BR (Bavarian Broadcasting) ha verificato che un'Intelligenza Artificiale può essere influenzata dalle apparenze. Ciò potrebbe riprodurre stereotipi e costare il lavoro ai candidati.

Leggi l'inchiesta e scopri cosa hanno analizzato i giornalisti

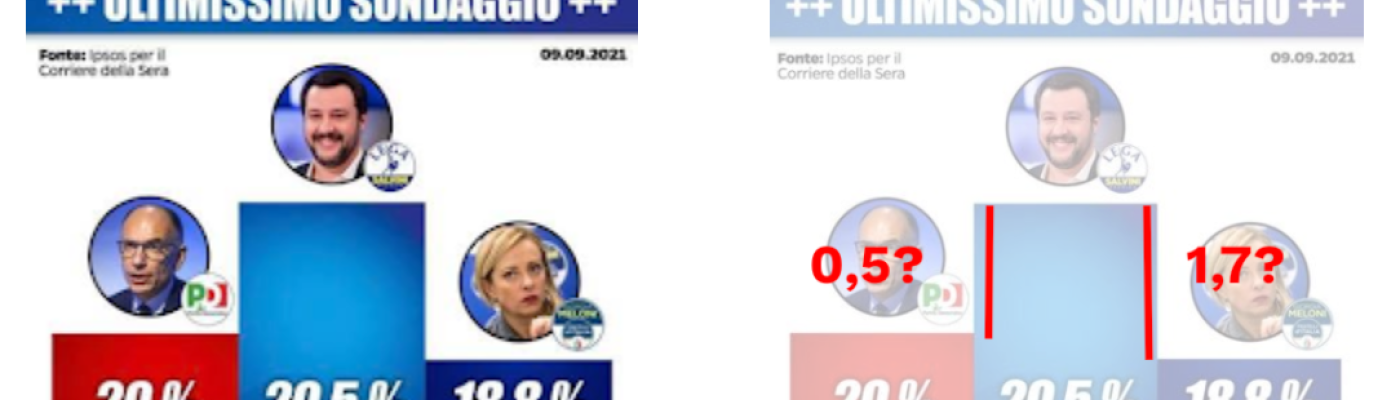

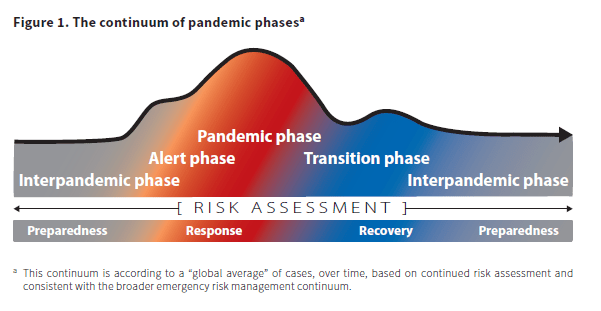

Tabelle, mappe, grafici, percentuali. Tra gli effetti positivi della pandemia, c'è stato senza dubbio l'aver sdoganato l'uso dei dati per prendere decisioni più informate e comunicare meglio con i cittadini. Questo processo non è stato però accompagnato da un'adeguata diffusione della cultura del dato. Spesso si pensa che basti usare una percentuale o un grafico per rendere automaticamente più credibile e scientifico un messaggio ("lo dicono i dati!").

E così abbiamo visto esperti, politici, giornalisti salire sul treno dei dati, senza essere molto consapevoli su come vadano raccolti, analizzati e comunicati. Molti leader hanno iniziato a usare il linguaggio dei dati per spingere la propria agenda e, in alcuni casi, apertamente manipolare e ingannare i cittadini.

Leggi l'articolo completo di Nicola Bruno

Negli ultimi anni molte società in tutto il mondo hanno cominciato a usare l’intelligenza artificiale per selezionare il personale da assumere, con lo scopo di eliminare dalla scelta eventuali pregiudizi e rischi di discriminazioni. Ma secondo gli esperti di tecnologia affidarsi a un algoritmo non è una soluzione, perché gli strumenti utilizzati tendono a imitare i preconcetti umani.

La mancanza di inclusività nelle squadre di programmatori e tecnici informatici, composte principalmente da uomini bianchi, si riflette infatti nei meccanismi automatici di selezione, penalizzando le donne e le persone lgbt+ o appartenenti alle minoranze.

Guarda il video della Thomson Reuters Foundation.

I motori di ricerca sono neutrali? Oppure ci manipolano? Come tutti gli algoritmi anche i motori di ricerca sono sostanzialmente matematica applicata, basati su grandi numeri (Big Data), cosa che conferisce loro generalmente un’aurea di obiettività.

Uno studio del 2021, dal titolo Visualizing Divergent Search Results Across Geopolitical Borders, di Rodrigo Ochigame e Katherine Ye, ha dato un contribuito alla discussione critica sulla neutralità dei motori di ricerca. Per fare ciò gli autori si sono avvalsi di un’interfaccia sperimentale, Search Atlas (qui l'annuncio del lancio), al fine di comprendere come funziona l’algoritmo di Google, e quali sono le differenze di risultati che presenta agli utenti.

Ad esempio, la ricerca “crimean annexation” mostra risultati differenti a seconda dell’impostazione del motore di ricerca. Per gli utenti russi la ricerca evidenzia che la Crimea è territorio russo, per gli ucraini si parla di “occupazione”, e così via.

Leggi l'articolo completo su Valigia Blu

Questi bias sono particolarmente rilevanti nella data visualization, aumentarne la consapevolezza può aiutarci a migliorare i nostri progetti data-driven

Il magazine di dataninja ha tradotto l'articolo che Lydia Hooper ha scritto per Nightingale.

Le nostre vite sono afflitte dall’incertezza. Facciamo affidamento sul design per riuscire a orientarci. Quando i progetti incorporano dati, possono suggerirci le informazioni di cui potremmo aver bisogno.

I progetti data-driven vengono utilizzati al meglio quando il contesto richiede alcune importanti decisioni e quando sono disponibili dati per l’orientamento. Ad esempio, in questo momento, il mondo è inondato di grafici destinati a spiegare la pandemia, in parte in modo da poter comprendere meglio i rischi e prendere decisioni di conseguenza.

Che ne siano consapevoli o meno, i designer spesso affrontano tali problemi con una serie di euristiche. Queste sono regole, principi generali o scorciatoie mentali che ci aiutano a prendere alcune decisioni rapide, come usare un linguaggio coerente e rendere leggibili i caratteri tipografici.

Le euristiche hanno lo scopo di aiutare nella risoluzione dei problemi, ma possono anche presentare una nuova serie di effetti indesiderati. Negli anni ’70 e ’80 gli psicologi Amos Tversky e Daniel Kahneman hanno gettato le basi per gli studi sulle euristiche e sui bias cognitivi (anche detti pregiudizi).

leggi l'articolo completo su dataninja magazine